È quasi impossibile sopravvalutare l’importanza e l’impatto di arXiv, l’archivio scientifico che, per un certo periodo, ha giustificato quasi da solo l’esistenza di Internet. ArXiv (pronunciato “archivio” o “Arr-ex-eye-vee” a seconda di chi chiedi) è un archivio di prestampa dove, dal 1991, scienziati e ricercatori hanno annunciato “ehi, ho appena scritto questo” al resto del mondo scientifico. La revisione tra pari si muove lentamente, ma è necessaria. ArXiv richiede solo una rapida verifica da parte di un moderatore anziché una revisione scrupolosa, quindi aggiunge un semplice passaggio intermedio tra la scoperta e la revisione tra pari, in cui tutte le ultime scoperte e innovazioni possono, con cautela, essere trattate con l’urgenza che meritano più o meno istantaneamente.

Ma l’uso dell’intelligenza artificiale ha ferito ArXiv e sta sanguinando. E non è chiaro che l’emorragia possa mai essere fermata.

Come a storia recente su The Atlantic osserva, Paul Ginsparg, creatore di ArXiv e professore di scienze dell’informazione alla Cornell, si è preoccupato sin dall’ascesa di ChatGPT che l’intelligenza artificiale possa essere utilizzata per superare le leggere ma necessarie barriere che impediscono la pubblicazione di spazzatura su ArXiv. L’anno scorso, Ginsparg ha collaborato a un’analisi che esaminava la probabile intelligenza artificiale nei contributi arXiv. In modo piuttosto terrificante, gli scienziati che evidentemente utilizzavano i LLM per generare documenti dall’aspetto plausibile erano più prolifici di quelli che non utilizzavano l’intelligenza artificiale. Il numero di articoli provenienti da poster di lavori scritti o aumentati dall’intelligenza artificiale è stato superiore del 33%.

L’intelligenza artificiale può essere utilizzata legittimamente, afferma l’analisi, per cose come superare la barriera linguistica. Continua:

“Tuttavia, i segnali tradizionali di qualità scientifica, come la complessità del linguaggio, stanno diventando indicatori di merito inaffidabili, proprio mentre stiamo sperimentando un aumento della quantità di lavoro scientifico. Man mano che i sistemi di intelligenza artificiale avanzano, metteranno alla prova i nostri presupposti fondamentali sulla qualità della ricerca, sulla comunicazione accademica e sulla natura del lavoro intellettuale”.

Non è solo ArXiv. Nel complesso è un momento difficile per l’affidabilità delle borse di studio in generale. Un sorprendente articolo pubblicato la scorsa settimana su Nature descriveva la disavventura dell’intelligenza artificiale di uno scienziato maldestro che lavorava in Germania di nome Marcel Bucher, che aveva utilizzato ChatGPT per generare e-mail, informazioni sui corsi, conferenze e take a look at. Come se ciò non bastasse, ChatGPT lo aiutava anche advert analizzare le risposte degli studenti e veniva incorporato nelle parti interattive del suo insegnamento. Poi un giorno, Bucher ha provato a disabilitare “temporaneamente” quella che ha chiamato l’opzione di “consenso ai dati”, e quando ChatGPT ha improvvisamente cancellato tutte le informazioni che stava archiviando esclusivamente nell’app, cioè sui server di OpenAI, si è lamentato sulle pagine di Nature che “due anni di lavoro accademico attentamente strutturato sono scomparsi”.

La diffusa pigrizia indotta dall’intelligenza artificiale mostrata proprio nell’space in cui ci si aspetta rigore e attenzione ai dettagli e si presume induca alla disperazione. Period lecito supporre che ci fosse un problema relativo al numero di pubblicazioni ha registrato un picco pochi mesi dopo il primo rilascio di ChatGPTma ora, come sottolinea The Atlantic, stiamo iniziando a ottenere i dettagli sulla reale sostanza e portata di quel problema: non tanto gli individui alla Bucher, drogati con l’intelligenza artificiale, che provano l’ansia di pubblicare o perire e si affrettano a pubblicare un giornale falso in fretta, ma una frode su scala industriale.

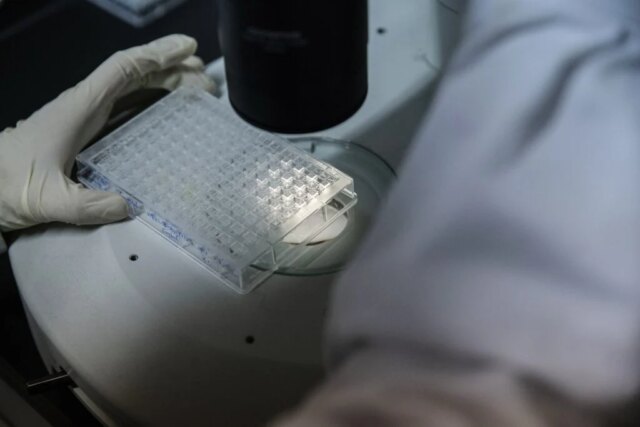

Advert esempio, nella ricerca sul cancro, i malintenzionati possono indurre a pubblicare documenti noiosi che pretendono di documentare “le interazioni tra una cellula tumorale e solo una proteina tra le molte migliaia che esistono”, osserva l’Atlantico. Se l’articolo afferma di essere innovativo, farà alzare le sopracciglia, il che significa che è più probabile che il trucco venga notato, ma se la falsa conclusione del falso esperimento sul cancro è una sciocchezza, sarà molto più probabile che quella sciocchezza venga pubblicata, anche in una pubblicazione credibile. Tanto meglio se si tratta di immagini generate dall’intelligenza artificiale di macchie di elettroforesi su gel che sono anche noiose, ma aggiungono ulteriore plausibilità a prima vista.

In breve, nella scienza è arrivata un’ondata di scarsa qualità e tutti devono diventare meno pigri, dagli accademici impegnati a pianificare le loro lezioni, ai revisori paritari e ai moderatori di ArXiv. Altrimenti, i depositi di conoscenza che erano tra le poche fonti di informazione affidabili rimaste stanno per essere sopraffatti dalla malattia che li ha già, forse irrevocabilmente, infettati. E il 2026 sembra un momento in cui chiunque, ovunque, diventerà meno pigro?