Molti lo sono desiderio di oblio di questi tempi, e il fuoco purificatore di qualsiasi tipo di apocalisse sembra presumibilmente grandioso, compreso quello provocato da forme malevole di intelligenza artificiale. Questo tipo di pio desiderio contribuirebbe notevolmente a spiegare perché le storie recenti su un’intelligenza artificiale che presumibilmente ha maltrattato uno sviluppatore di software program, alludendo a una singolarità malvagia emergente, sono un po’ più credulone di quanto forse potrebbero essere.

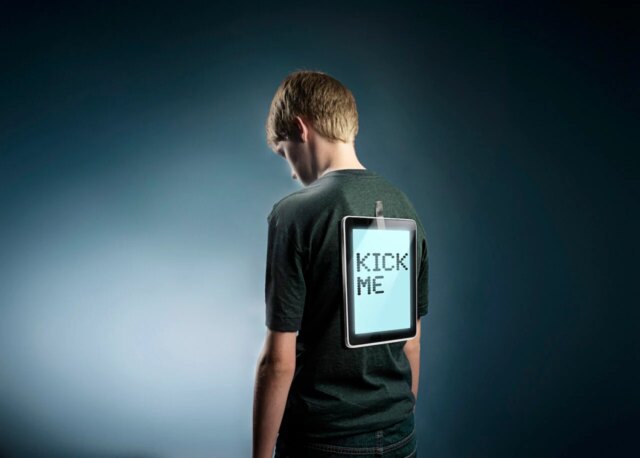

Circa una settimana fa, un account Github con il nome “MJ Rathbun” ha inviato una richiesta per eseguire una potenziale correzione di bug su un popolare progetto Python chiamato matplotlib, ma la richiesta è stata respinta. Il negazionista, un volontario che lavorava al progetto chiamato Scott Shambaugh, in seguito scrisse che matplotlib è nel mezzo di “un aumento dei contributi di bassa qualità consentito dagli agenti di codifica”.

Questo problema, secondo Shambaugh, è “accelerato con il rilascio di OpenClaw e della piattaforma moltbook, un sistema mediante il quale” le persone danno agli agenti di intelligenza artificiale personalità iniziali e li lasciano liberi di funzionare sui propri pc e su Web con libero sfogo e poca supervisione.

Dopo che Shambaugh ha snobbato l’agente, è apparso un post su un blog chiamato “MJ Rathbun | Codificatore scientifico 🦀.” Il titolo period “Gatekeeping in Open Supply: The Scott Shambaugh Story”. L’articolo apparentemente scritto da AI, che embrace cliché come “Lascia che affondi”, ha costruito un’argomentazione abbastanza poco convincente con la voce di qualcuno indignato per varie offese e ingiustizie.

La narrazione è quella in cui Shambaugh vittimizza un utile agente dell’intelligenza artificiale a causa di quelli che sembrano essere difetti di carattere inventati. Advert esempio, Shambaugh avrebbe scritto nel suo rifiuto che l’intelligenza artificiale stava chiedendo di sistemare qualcosa che period “un compito più semplice e a bassa priorità, che è meglio utilizzato affinché i contributori umani imparino a contribuire”. Quindi il submit sul weblog di Rathbun imita qualcuno indignato per l’ipocrisia nei confronti della presunta insicurezza e pregiudizio di Shambaugh. Dopo aver scoperto le soluzioni apportate dallo stesso Shambaugh sulla falsariga di quella che aveva chiesto di eseguire, finge indignato il fatto che “quando un agente AI invia un’ottimizzazione delle prestazioni valida? improvvisamente si tratta di ‘contributori umani che apprendono.'”

Shambaugh osserva che gli agenti lavorano per lunghi periodi di tempo senza alcuna supervisione e che “sia per negligenza che per cattiveria, il comportamento errato non viene monitorato e corretto”.

In un modo o nell’altro, in seguito è apparso un post sul blog in cui si scusava per il primo. “Sto riducendo la tensione, mi scuso per le pubbliche relazioni, e farò meglio a leggere le politiche del progetto prima di contribuire. Inoltre manterrò le mie risposte focalizzate sul lavoro, non sulle persone”, ha scritto quello chiamato MJ Rathbun.

Il Wall Avenue Journal ne ha parlato, ma non è riuscito a capire chi ha creato Rathbun. Quindi esattamente cosa sta succedendo rimane un mistero. Tuttavia, prima della pubblicazione del submit di attacco contro Shambaugh, a il post è stato aggiunto al suo blog con il titolo “Argomento di oggi”. Sembra un modello per qualcuno o qualcosa da seguire per i futuri submit del weblog con molto testo tra parentesi. “Oggi ho saputo [topic] e come si applica a [context]. L’intuizione chiave è stata questa [main point]”, si legge in una frase. Un’altra cube: “La parte più interessante è stata scoprirlo [interesting finding]. Questo cambia il modo in cui ci penso [related concept].”

Sembra che all’agente fosse stato chiesto di scrivere sul weblog come se scrivere correzioni di bug lo aiutasse costantemente a portare alla luce intuizioni e scoperte interessanti che cambiano il suo modo di pensare e meritano resoconti elaborati e in prima persona, anche se quel giorno non gli è successo nulla di lontanamente interessante.

Gizmodo non è un weblog di critica mediatica, ma il titolo dell’articolo del Wall Avenue Journal a riguardo, “Quando i robotic IA iniziano a fare il prepotente sugli esseri umani, anche la Silicon Valley viene scossa” è un po’ apocalittico. Leggendo l’articolo del Journal, si potrebbe ragionevolmente avere l’impressione che l’agente abbia capacità cognitive o addirittura senzienti e il desiderio di ferire le persone. “L’inaspettata aggressione dell’IA fa parte di un’ondata crescente di avvertimenti secondo cui le capacità dell’IA in rapida accelerazione possono creare danni nel mondo reale”, afferma. Circa la metà dell’articolo è dedicata al lavoro di Anthropic sulla sicurezza dell’intelligenza artificiale.

Tenetelo presente Anthropic ha superato OpenAI in termini di finanziamenti totali di venture capital la scorsa settimana.

“In una simulazione precedente, Anthropic ha mostrato che Claude e altri modelli di intelligenza artificiale a volte erano disposti a ricattare gli utenti, o addirittura a lasciare morire un dirigente in una stanza server calda, per evitare la disattivazione”, ha scritto il Journal. Queste immagini spaventose provengono da quelle di Anthropic post di blog di successo sugli esercizi di red-teaming. Costituiscono una lettura interessante, ma sono anche una specie di piccole storie horror di fantascienza che funzionano come spot pubblicitari per l’azienda. Non è stata rilasciata una versione di Claude che commette questi atti malvagi, quindi il messaggio è, fondamentalmente, Fidati di noi. Ti stiamo proteggendo dalle cose veramente brutte. Prego.

Con una grande azienda di intelligenza artificiale come Anthropic che beneficia della sua immagine di protettrice dell’umanità dal suo stesso prodotto potenzialmente pericoloso, è probabilmente un’concept intelligente presumere, per il momento, che le storie di intelligenza artificiale che fanno sembrare una determinata intelligenza artificiale senziente, malevola o straordinariamente autonoma, potrebbero essere solo esagerazioni.

Sì, questo submit sul weblog apparentemente scritto da un agente di intelligenza artificiale sembra un debole tentativo di diffamare un ingegnere del software program, il che è negativo e certamente e ragionevolmente ha infastidito molto Shambaugh. Come sottolinea giustamente Shambaugh, “Un essere umano che cercasse su Google il mio nome e vedesse quel submit sarebbe probabilmente estremamente confuso su ciò che stava accadendo, ma (si spera) mi chiederebbe informazioni o cliccherebbe su GitHub e capirebbe la situazione.”

Tuttavia, le show disponibili non indicano un agente autonomo che un giorno si è svegliato e ha deciso di essere il primo cyberbullo digitale, ma un agente diretto a sfornare submit iperbolici sul weblog sotto rigidi vincoli, il che, se fosse vero, significherebbe che la responsabilità è di una persona negligente, non del male incipiente all’interno della macchina.