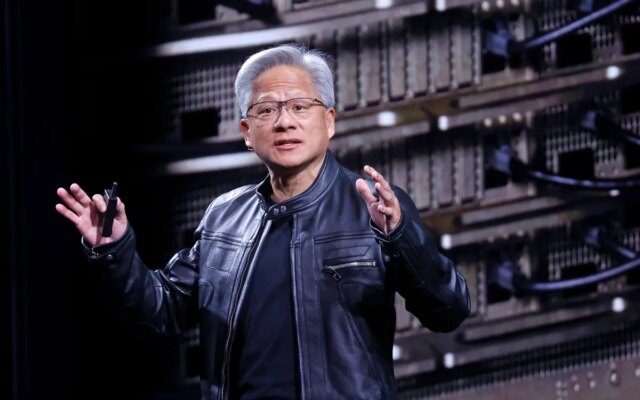

Oggi al Shopper Electronics Present, il CEO di Nvidia Jensen Huang ha lanciato ufficialmente la nuova architettura informatica Rubin dell’azienda, che ha descritto come lo stato dell’arte nell'{hardware} AI. La nuova architettura è attualmente in produzione e se ne prevede un ulteriore sviluppo nella seconda metà dell’anno.

“Vera Rubin è progettata per affrontare questa sfida fondamentale che abbiamo davanti: la quantità di calcoli necessari per l’intelligenza artificiale è alle stelle”. Huang ha detto al pubblico. “Oggi posso dirvi che Vera Rubin è in piena produzione”.

L’architettura Rubin, annunciata per la prima volta nel 2024è l’ultimo risultato dell’instancabile ciclo di sviluppo {hardware} di Nvidia, che ha trasformato Nvidia nella società più preziosa al mondo. L’architettura Rubin sostituirà l’architettura Blackwell, che a sua volta ha sostituito le architetture Hopper e Lovelace.

I chip Rubin sono già previsti per l’utilizzo da parte di quasi tutti i principali fornitori di servizi cloud, comprese le partnership di alto profilo con Nvidia Antropico, OpenAIE Servizi Web di Amazon. Verranno utilizzati anche i sistemi Rubin Il supercomputer Blue Lion di HPE E il prossimo supercomputer Doudna al Laboratorio Nazionale Lawrence Berkeley.

Chiamato per l’astronomo Vera Florence Cooper Rubinl’architettura Rubin è composta da sei chip separati progettati per essere utilizzati in concerto. La GPU Rubin è al centro, ma l’architettura affronta anche i crescenti colli di bottiglia nello storage e nell’interconnessione con nuovi miglioramenti rispettivamente nei sistemi Bluefield e NVLink. L’architettura embrace anche una nuova CPU Vera, progettata per il ragionamento advert agenti.

Spiegando i vantaggi del nuovo storage, Dion Harris, direttore senior delle soluzioni infrastrutturali AI di Nvidia, ha sottolineato le crescenti richieste di memoria legate alla cache dei moderni sistemi AI.

“Quando inizi advert abilitare nuovi tipi di flussi di lavoro, come l’intelligenza artificiale agentica o attività a lungo termine, ciò mette molto stress e requisiti sulla tua cache KV”, ha detto Harris ai giornalisti durante una chiamata, riferendosi a un sistema di memoria utilizzato dai modelli di intelligenza artificiale per condensare gli enter. “Abbiamo quindi introdotto un nuovo livello di storage che si connette esternamente al dispositivo di elaborazione, consentendoti di scalare il tuo pool di storage in modo molto più efficiente.”

Evento Techcrunch

San Francisco

|

13-15 ottobre 2026

Come previsto, la nuova architettura rappresenta anche un progresso significativo in termini di velocità ed efficienza energetica. Secondo i check di Nvidia, l’architettura Rubin funzionerà tre volte e mezzo più velocemente della precedente architettura Blackwell nelle attività di model-training e cinque volte più velocemente nelle attività di inferenza, raggiungendo fino a 50 petaflop. La nuova piattaforma supporterà inoltre un numero di calcoli di inferenza per watt otto volte superiore.

Le nuove funzionalità di Rubin arrivano in un contesto di intensa concorrenza per costruire infrastrutture di intelligenza artificiale, che ha visto sia i laboratori di intelligenza artificiale che i fornitori di servizi cloud lottare per i chip Nvidia e le strutture necessarie per alimentarli. In una riunione sugli utili dell’ottobre 2025, Huang ha stimato che tra i 3 e i 4 trilioni di dollari saranno spesi per le infrastrutture di intelligenza artificiale nei prossimi cinque anni.

Segui tutta la copertura di TechCrunch della conferenza annuale del CES qui.