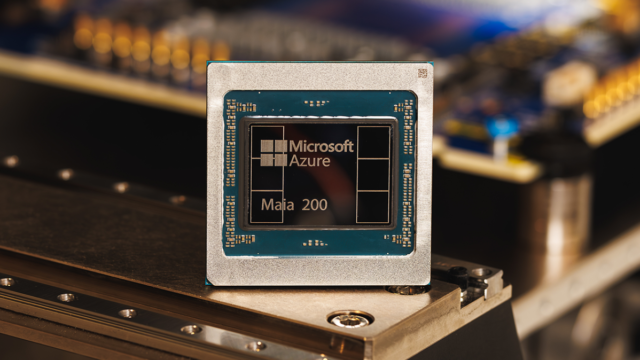

Microsoft ha annunciato il lancio del suo ultimo chip, il Maia 200, che l’azienda descrive come un cavallo di battaglia in silicio progettato per scalare l’inferenza dell’intelligenza artificiale.

Il 200, che segue quello dell’azienda Maia 100 rilasciato nel 2023è stato tecnicamente attrezzato per eseguire potenti modelli di intelligenza artificiale a velocità più elevate e con maggiore efficienza, ha affermato la società. Maia è dotato di oltre 100 miliardi di transistor, che forniscono oltre 10 petaflop con precisione a 4 bit e circa 5 petaflop con prestazioni a 8 bit: un aumento sostanziale rispetto al suo predecessore.

L’inferenza si riferisce al processo di calcolo dell’esecuzione di un modello, in contrasto con il calcolo richiesto per addestrarlo. Man mano che le aziende di intelligenza artificiale maturano, i costi di inferenza sono diventati una parte sempre più importante dei loro costi operativi complessivi, portando a un rinnovato interesse sui modi per ottimizzare il processo.

Microsoft spera che Maia 200 possa far parte di questa ottimizzazione, consentendo alle aziende di intelligenza artificiale di funzionare con meno interruzioni e un minore consumo energetico. “In termini pratici, un nodo Maia 200 può gestire senza sforzo i modelli più grandi di oggi, con ampio margine per modelli ancora più grandi in futuro”, ha affermato l’azienda.

Il nuovo chip di Microsoft fa parte anche di una tendenza crescente di giganti della tecnologia che si rivolgono a chip auto-progettati come un modo per ridurre la loro dipendenza da Nvidia, la cui GPU all’avanguardia sono diventati sempre più cruciali per il successo delle aziende di intelligenza artificiale. Google, advert esempio, ha le sue TPU, le unità di elaborazione tensore, che non vengono vendute come chip ma come potenza di calcolo resa accessibile attraverso il suo cloud. Poi c’è Amazon Trainium, il chip acceleratore AI del gigante dell’e-commerce, che ha appena lanciato la sua ultima versioneil Trainium3, a dicembre. In ogni caso, i TPU possono essere utilizzati per scaricare parte del calcolo che altrimenti verrebbe assegnato alle GPU Nvidia, riducendo il costo {hardware} complessivo.

Con Maia, Microsoft si posiziona per competere con queste different. Nel suo comunicato stampa di lunedì, la società ha osservato che Maia offre prestazioni FP4 3 volte superiori ai chip Amazon Trainium di terza generazione e prestazioni FP8 superiori al TPU di settima generazione di Google.

Microsoft afferma che Maia è già al lavoro per alimentare i modelli di intelligenza artificiale dell’azienda dal suo crew di Superintelligence. Ha inoltre supportato le operazioni di Copilot, il suo chatbot. Lunedì, la società ha dichiarato di aver invitato una serie di soggetti, tra cui sviluppatori, accademici e laboratori di intelligenza artificiale di frontiera, a utilizzare il package di sviluppo software program Maia 200 nei propri carichi di lavoro.

Evento Techcrunch

San Francisco

|

13-15 ottobre 2026