Le aziende si sono mosse rapidamente per adottare RAG per radicare i LLM nei dati proprietari. In pratica, tuttavia, molte organizzazioni stanno scoprendo che il recupero non è più una funzionalità legata all’inferenza del modello: è diventata una dipendenza fondamentale del sistema.

Una volta che i sistemi di intelligenza artificiale vengono implementati per supportare il processo decisionale, automatizzare i flussi di lavoro o operare in modo semi-autonomo, gli errori nel recupero si propagano direttamente nel rischio aziendale. Il contesto obsoleto, i percorsi di accesso non governati e le pipeline di recupero scarsamente valutate non si limitano a degradare la qualità delle risposte; minano la fiducia, la conformità e l’affidabilità operativa.

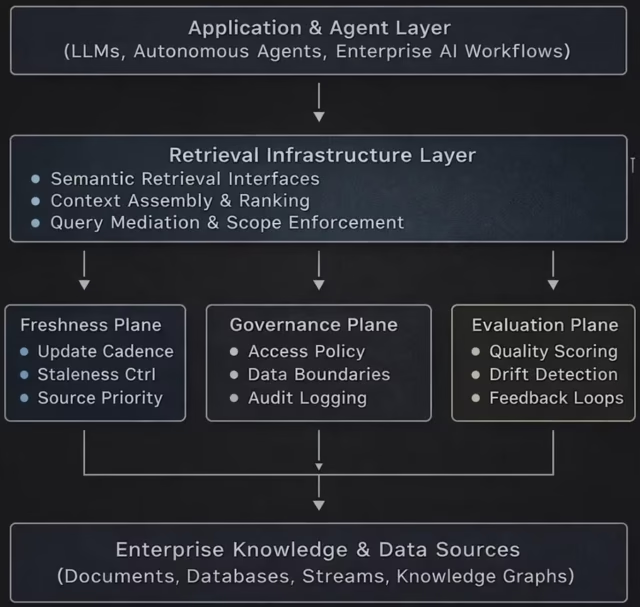

Questo articolo riformula il recupero come infrastruttura piuttosto che come logica applicativa. Introduce un modello a livello di sistema per la progettazione di piattaforme di recupero che supportano freschezza, governance e valutazione come preoccupazioni architettoniche di prima classe. L’obiettivo è aiutare gli architetti aziendali, i chief delle piattaforme AI e i staff dell’infrastruttura dati a ragionare sui sistemi di recupero con lo stesso rigore storicamente applicato all’elaborazione, alla rete e allo storage.

Recupero come infrastruttura: un’architettura di riferimento che illustra come freschezza, governance e valutazione funzionano come piani di sistema di prima classe piuttosto che come logica applicativa incorporata. Diagramma concettuale creato dall’autore.

Perché RAG fallisce su scala aziendale

Le prime implementazioni RAG erano progettate per casi d’uso ristretti: ricerca di documenti, domande e risposte interne e copiloti che operano in domini ristretti. Questi progetti presupponevano corpora relativamente statici, modelli di accesso prevedibili e supervisione umana nel ciclo. Tali presupposti non reggono più.

I moderni sistemi di intelligenza artificiale aziendale si affidano sempre più a:

-

Origini dati in continua evoluzione

-

Ragionamento in più fasi tra domini

-

Flussi di lavoro gestiti da agenti che recuperano il contesto in modo autonomo

-

Requisiti normativi e di controllo legati all’utilizzo dei dati

In questi ambienti, gli errori di recupero si aggravano rapidamente. Un singolo indice obsoleto o una coverage di accesso con ambito errato possono estendersi a più decisioni a valle. Trattare il recupero come un leggero miglioramento della logica di inferenza oscura il suo ruolo crescente come superficie di rischio sistemico.

La freschezza del recupero è un problema di sistema, non un problema di ottimizzazione

I fallimenti di freschezza raramente hanno origine nell’incorporamento di modelli. Hanno origine nel sistema circostante.

La maggior parte degli stack di recupero aziendale fatica a rispondere alle domande operative di base:

-

Con quale rapidità le modifiche all’origine si propagano negli indici?

-

Quali consumatori mettono ancora in discussione rappresentazioni superate?

-

Quali garanzie esistono quando i dati cambiano nel corso della sessione?

Nelle piattaforme mature, l’aggiornamento viene rafforzato attraverso meccanismi architettonici espliciti anziché ricostruzioni periodiche. Questi includono la reindicizzazione basata sugli eventi, gli incorporamenti con versione e la consapevolezza in tempo di recupero della obsolescenza dei dati.

Nelle distribuzioni aziendali, lo schema ricorrente è che i problemi di aggiornamento raramente derivano dall’integrazione della qualità; emergono quando i sistemi di origine cambiano continuamente mentre le pipeline di indicizzazione e incorporamento si aggiornano in modo asincrono, lasciando che i consumatori di recupero operino inconsapevolmente su un contesto obsoleto. Poiché il sistema continua a produrre risposte fluide e plausibili, queste lacune spesso passano inosservate finché i flussi di lavoro autonomi non dipendono dal recupero continuo e i problemi di affidabilità emergono su larga scala.

La governance deve estendersi al livello di recupero

La maggior parte dei modelli di governance aziendale sono stati progettati per l’accesso ai dati e l’utilizzo del modello in modo indipendente. I sistemi di recupero si collocano scomodamente tra i due.

Il recupero non governato introduce diversi rischi:

-

Modelli che accedono ai dati al di fuori dell’ambito previsto

-

Campi sensibili che fuoriescono attraverso gli incorporamenti

-

Agenti che recuperano informazioni su cui non sono autorizzati advert agire

-

Incapacità di ricostruire quali dati abbiano influenzato una decisione

Nelle architetture incentrate sul recupero, la governance deve operare ai confini semantici anziché solo a livello di storage o API. Ciò richiede l’applicazione di coverage legate a question, incorporamenti e consumatori a valle, non solo a set di dati.

Una governance efficace del recupero in genere embrace:

-

Indici con ambito di dominio con proprietà esplicita

-

API di recupero sensibili alle coverage

-

Tracce di controllo che collegano le question agli artefatti recuperati

-

Controlli sul recupero tra domini da parte di agenti autonomi

Senza questi controlli, i sistemi di recupero ignorano silenziosamente le misure di sicurezza che le organizzazioni presumono siano in atto.

La valutazione non può fermarsi alla qualità delle risposte

La valutazione RAG tradizionale si concentra sulla correttezza delle risposte. Ciò non è sufficiente per i sistemi aziendali.

Gli errori di recupero spesso si manifestano a monte della risposta finale:

-

Recuperati documenti irrilevanti ma plausibili

-

Contesto critico mancante

-

Sovrarappresentazione di fonti out of date

-

Esclusione silenziosa dei dati autorevoli

Man mano che i sistemi di intelligenza artificiale diventano più autonomi, i staff devono valutare il recupero come un sottosistema indipendente. Ciò embrace la misurazione del richiamo in base a vincoli politici, il monitoraggio della deriva della freschezza e il rilevamento delle distorsioni introdotte dai percorsi di recupero.

Negli ambienti di produzione, la valutazione tende a interrompersi una volta che il recupero diventa autonomo anziché attivato dall’uomo. I staff continuano a valutare la qualità delle risposte sui immediate campionati, ma non hanno visibilità su cosa è stato recuperato, cosa è mancato o se il contesto obsoleto o non autorizzato ha influenzato le decisioni. Man mano che i percorsi di recupero si evolvono dinamicamente nella produzione, la deriva silenziosa si accumula a monte e, quando i problemi emergono, i fallimenti vengono spesso attribuiti erroneamente al comportamento del modello piuttosto che al sistema di recupero stesso.

La valutazione che ignora il comportamento di recupero lascia le organizzazioni cieche rispetto alle vere trigger del fallimento del sistema.

Piani di controllo che governano il comportamento di recupero

Cmodello di piano di controllo per sistemi di recupero aziendale, che separa l’esecuzione dalla governance per consentire l’applicazione delle coverage, la verificabilità e la valutazione continua. Diagramma concettuale creato dall’autore.

Un’architettura di riferimento: il recupero come infrastruttura

Un sistema di recupero progettato per l’intelligenza artificiale aziendale è in genere costituito da cinque livelli interdipendenti:

-

Livello di importazione dell’origine: Gestisce dati strutturati, non strutturati e in streaming con tracciamento della provenienza.

-

Livello di incorporamento e indicizzazione: Supporta il controllo delle versioni, l’isolamento del dominio e la propagazione controllata degli aggiornamenti.

-

Livello di politica e governance: Applica controlli di accesso, confini semantici e verificabilità al momento del recupero.

-

Livello di valutazione e monitoraggio: Misura l’aggiornamento, il richiamo e l’aderenza alle coverage indipendentemente dall’output del modello.

-

Strato di consumo: Serve esseri umani, applicazioni e agenti autonomi con vincoli contestuali.

Questa architettura tratta il recupero come un’infrastruttura condivisa piuttosto che come una logica specifica dell’applicazione, consentendo un comportamento coerente tra i casi d’uso.

Perché il recupero determina l’affidabilità dell’IA

Mentre le aziende si spostano verso sistemi advert agenti e flussi di lavoro basati sull’intelligenza artificiale a lungo termine, il recupero diventa il substrato da cui dipende il ragionamento. I modelli possono essere affidabili solo nella misura in cui lo è il contesto a cui vengono forniti.

Le organizzazioni che continuano a considerare il recupero come una preoccupazione secondaria avranno difficoltà a:

-

Comportamento del modello inspiegabile

-

Lacune di conformità

-

Prestazioni del sistema incoerenti

-

Erosione della fiducia degli stakeholder

Coloro che elevano il recupero a una disciplina infrastrutturale – governata, valutata e progettata per il cambiamento – ottengono una base che si adatta sia all’autonomia che al rischio.

Conclusione

Il recupero non è più una funzionalità di supporto dei sistemi di intelligenza artificiale aziendale. È l’infrastruttura.

Freschezza, governance e valutazione non sono ottimizzazioni opzionali; sono prerequisiti per l’implementazione di sistemi di intelligenza artificiale che funzionino in modo affidabile in ambienti reali. Man mano che le organizzazioni si spingono oltre le implementazioni RAG sperimentali verso sistemi autonomi e di supporto alle decisioni, il trattamento architetturale del recupero determinerà sempre più il successo o il fallimento.

Le imprese che riconoscono tempestivamente questo cambiamento saranno in una posizione migliore per scalare l’intelligenza artificiale in modo responsabile, resistere al controllo normativo e mantenere la fiducia man mano che i sistemi diventano più capaci e consequenziali.

Varun Raj è un dirigente di ingegneria del cloud e dell’intelligenza artificiale specializzato nella modernizzazione del cloud su scala aziendale, architetture native dell’intelligenza artificiale e sistemi distribuiti su larga scala.

Benvenuto nella comunità VentureBeat!

Il nostro programma di visitor posting è il luogo in cui gli esperti tecnici condividono approfondimenti e forniscono approfondimenti neutrali e non conferiti su intelligenza artificiale, infrastruttura dati, sicurezza informatica e altre tecnologie all’avanguardia che plasmano il futuro dell’impresa.

Per saperne di più dal nostro programma di submit per gli ospiti e dai un’occhiata al nostro linee guida se sei interessato a contribuire con un tuo articolo!