Molti nel settore pensano che i vincitori del mercato dei modelli di intelligenza artificiale siano già stati decisi: Huge Tech ne sarà proprietario (Google, Meta, Microsoft, un po’ di Amazon) insieme ai loro produttori di modelli preferiti, in gran parte OpenAI e Anthropic.

Ma la piccola startup Arcee AI, composta da 30 persone, non è d’accordo. L’azienda ha appena rilasciato un modello di fondazione per scopi generici veramente e permanentemente aperto (licenza Apache), chiamato Trinity, e Arcee afferma che con parametri di 400B, è tra i più grandi modelli di fondazione open supply mai formati e rilasciati da un’azienda statunitense.

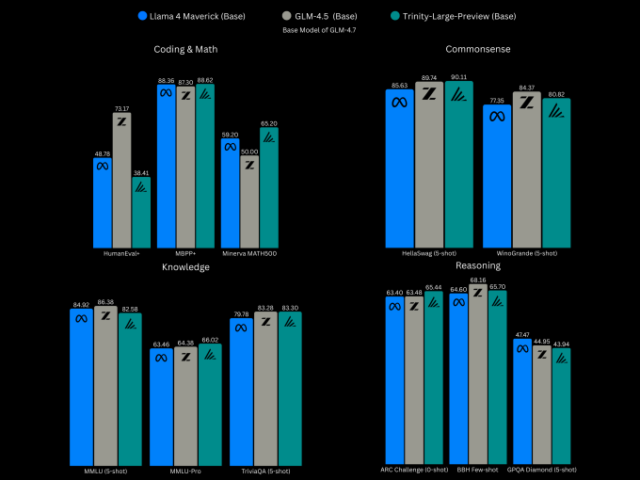

Arcee afferma che Trinity può essere paragonato al Llama 4 Maverick 400B di Meta e allo Z.ai GLM-4.5, un modello open supply advert alte prestazioni dell’Università cinese Tsinghua, secondo check di benchmark condotti utilizzando modelli di base (molto poco post-addestramento).

Come altri modelli all’avanguardia (SOTA), Trinity è progettato per la codifica e processi multi-fase come gli agenti. Tuttavia, nonostante le sue dimensioni, non è ancora un vero concorrente di SOTA perché attualmente supporta solo testo.

Altre modalità sono in lavorazione: un modello di visione è attualmente in fase di sviluppo e una versione di sintesi vocale è sulla tabella di marcia, ha detto a TechCrunch il CTO Lucas Atkins (nella foto sopra, a sinistra). In confronto, Llama 4 Maverick di Meta è già multimodale e supporta testo e immagini.

Ma prima di aggiungere altre modalità AI al suo elenco, Arcee afferma che voleva un LLM di base che impressionasse i suoi principali clienti goal: sviluppatori e accademici. Il crew vuole in particolare convincere le aziende statunitensi di tutte le dimensioni a rinunciare alla scelta dei modelli aperti provenienti dalla Cina.

“Alla advantageous, i vincitori di questo gioco, e l’unico modo per vincere davvero sull’utilizzo, è avere il miglior modello a peso aperto”, ha detto Atkins. “Per conquistare i cuori e le menti degli sviluppatori, devi dare loro il meglio.”

Evento Techcrunch

San Francisco

|

13-15 ottobre 2026

I benchmark mostrano che il modello base Trinity, attualmente in anteprima mentre si svolge più post-formazione, sta in gran parte reggendo e, in alcuni casi, superando leggermente Llama nei check di codifica e matematica, buon senso, conoscenza e ragionamento.

I progressi compiuti finora da Arcee per diventare un laboratorio di intelligenza artificiale competitivo sono impressionanti. Segue il grande modello Trinity due precedenti modelli piccoli rilasciato a dicembre: il Trinity Mini con parametri 26B, un modello di ragionamento completamente post-addestrato per attività che vanno dalle app Internet agli agenti, e il Trinity Nano con parametri 6B, un modello sperimentale progettato per ampliare i confini dei modelli piccoli ma loquaci.

La cosa bella è che Arcee li ha addestrati tutti in sei mesi per un totale di 20 milioni di dollari, utilizzando 2.048 GPU Nvidia Blackwell B300. Questo dei circa 50 milioni di dollari che la società ha raccolto finora, ha affermato il fondatore e CEO Mark McQuade (nella foto sopra, a destra).

Quella somma di denaro period “molto per noi”, ha detto Atkins, che ha guidato lo sforzo di costruzione del modello. Tuttavia, ha riconosciuto che ciò impallidisce in confronto a quanto stanno spendendo i laboratori più grandi in questo momento.

La tempistica di sei mesi “period molto calcolata”, ha detto Atkins, la cui carriera prima dei LLM prevedeva la costruzione di agenti vocali per le automobili. “Siamo una startup più giovane ed estremamente affamata. Abbiamo un’enorme quantità di talento e giovani ricercatori brillanti che, quando abbiamo avuto l’opportunità di spendere questa somma di denaro e formare un modello di queste dimensioni, confidavamo che sarebbero stati all’altezza della situazione. E certamente lo hanno fatto, con molte notti insonni e molte lunghe ore.”

McQuade, in passato uno dei primi dipendenti del mercato di modelli open supply HuggingFace, afferma che Arcee non ha iniziato con il desiderio di diventare un nuovo laboratorio di intelligenza artificiale statunitense: originariamente la società stava personalizzando i modelli per grandi clienti aziendali come SK Telecom.

“Stavamo facendo solo post-formazione. Quindi avremmo preso il grande lavoro degli altri: avremmo preso un modello Llama, avremmo preso un modello Mistral, avremmo preso un modello Qwen che period open supply, e lo avremmo post-addestrato per renderlo migliore” per l’uso previsto da un’azienda, ha detto, compreso l’apprendimento per rinforzo.

Ma man mano che la loro lista di clienti cresceva, ha detto Atkins, la necessità di un proprio modello stava diventando una necessità, e McQuade period preoccupato di affidarsi advert altre società. Allo stesso tempo, molti dei migliori modelli aperti provenivano dalla Cina, verso il quale le imprese statunitensi erano diffidenti o a cui veniva impedito di utilizzare.

È stata una decisione snervante. “Penso che ci siano meno di 20 aziende al mondo che abbiano mai pre-addestrato e rilasciato il proprio modello” alle dimensioni e al livello a cui Arcee puntava, ha detto McQuade.

Inizialmente l’azienda ha iniziato in piccolo, cimentandosi con un minuscolo modello da 4,5 miliardi creato in collaborazione con la società di formazione DatologyAI. Il successo del progetto ha quindi incoraggiato sforzi più grandi.

Ma se gli Stati Uniti hanno già il Llama, perché hanno bisogno di un altro modello a peso aperto? Atkins afferma che scegliendo la licenza open supply Apache, la startup si impegna a mantenere sempre aperti i suoi modelli. Ciò avviene dopo che l’amministratore delegato di Meta, Mark Zuckerberg, l’anno scorso ha indicato che la sua azienda potrebbe non rendere sempre open supply tutti i suoi modelli più avanzati.

“Llama può essere considerato non veramente open supply in quanto utilizza una licenza controllata da Meta con avvertenze commerciali e di utilizzo”, afferma. Ciò ha causato alcune organizzazioni open source da rivendicare che Llama non è affatto compatibile con l’open supply.

“Arcee esiste perché gli Stati Uniti hanno bisogno di un’alternativa di frontiera permanentemente aperta, con licenza Apache, che possa effettivamente competere alla frontiera odierna”, ha affermato McQuade.

Tutti i modelli Trinity, grandi e piccoli, possono essere scaricati gratuitamente. La versione più grande sarà rilasciata in tre gusti. Trinity Giant Preview è un modello di istruzioni leggermente post-addestrato, il che significa che è stato addestrato per seguire le istruzioni umane, non solo per prevedere la parola successiva, che lo adatta all’utilizzo generale della chat. Trinity Giant Base è il modello base senza post-training.

Poi abbiamo TrueBase, un modello con qualsiasi istruzione o post-formazione in modo che le aziende o i ricercatori che desiderano personalizzarlo non debbano srotolare dati, regole o ipotesi.

Acree AI alla advantageous offrirà una versione ospitata del suo modello di rilascio generale a prezzi API competitivi. Mancano sei settimane a story rilascio poiché la startup continua a migliorare la formazione del ragionamento del modello.

Il prezzo API per Trinity-Mini è $ 0,045 / $ 0,15 ed è disponibile anche un livello gratuito a tariffa limitata. Nel frattempo, l’azienda vende ancora opzioni di post-formazione e personalizzazione.