Alibaba ha abbandonato Qwen3.5 all’inizio di questa settimana, in concomitanza con il Capodanno lunare, e i numeri dei titoli da soli sono sufficienti per far sì che gli acquirenti di IA aziendali si fermino e prestino attenzione.

Il nuovo modello open-weight di punta, Qwen3.5-397B-A17B, racchiude 397 miliardi di parametri totali ma ne attiva solo 17 miliardi per token. Sta rivendicando vittorie nei benchmark rispetto al precedente fiore all’occhiello di Alibaba, Qwen3-Max, un modello che la società stessa ha riconosciuto ha superato i trilioni di parametri.

Il rilascio segna un momento significativo nell’approvvigionamento di IA aziendale. Per i chief IT che stanno valutando l’infrastruttura AI per il 2026, Qwen 3.5 presenta un diverso tipo di argomento: che il modello che puoi effettivamente eseguire, possedere e controllare può ora scontrarsi con i modelli che devi noleggiare.

Una nuova architettura costruita per la velocità su larga scala

La storia ingegneristica di Qwen3.5 inizia con i suoi antenati. Il modello è il diretto successore del Qwen3-Subsequent sperimentale dello scorso settembre, un modello MoE ultra-sparso che period stato previsto in anteprima ma ampiamente considerato come semiaddestrato. Qwen3.5 prende questa direzione architetturale e la ridimensiona in modo aggressivo, passando dai 128 esperti dei precedenti modelli Qwen3 MoE ai 512 esperti della nuova versione.

L’implicazione pratica di questo e di un migliore meccanismo di attenzione è una latenza di inferenza notevolmente inferiore. Poiché solo 17 miliardi di questi 397 miliardi di parametri sono attivi per ogni dato passaggio in avanti, l’impronta di calcolo è molto più vicina a un modello denso da 17 miliardi che a uno da 400 miliardi, mentre il modello può attingere a tutta la profondità del suo pool di esperti per ragionamenti specializzati.

Questi guadagni di velocità sono sostanziali. Con una lunghezza di contesto di 256K, Qwen 3.5 decodifica 19 volte più velocemente di Qwen3-Max e 7,2 volte più velocemente del modello 235B-A22B di Qwen 3.

Alibaba sostiene inoltre che il modello è più economico del 60% rispetto al suo predecessore e otto volte più capace di gestire grandi carichi di lavoro simultanei, cifre che contano enormemente per qualsiasi group che presti attenzione ai conti di inferenza. È anche circa 1/18esimo del costo del Gemini 3 Professional di Google.

Altre due decisioni architetturali contribuiscono a questi vantaggi:

-

Qwen3.5 adotta la previsione multi-token – un approccio sperimentato in diversi modelli proprietari – che accelera la convergenza pre-formazione e aumenta la produttività.

-

Anche eredita il sistema di attenzione da Qwen3-Avanti rilasciato lo scorso anno, progettato specificamente per ridurre la pressione della memoria su contesti di durata molto lunga.

Il risultato è un modello che può operare comodamente all’interno di una finestra di contesto di 256K nella versione open-weight e fino a 1 milione di token nella variante Qwen3.5-Plus ospitata su Alibaba Cloud Mannequin Studio.

Multimodale nativo, non imbullonato

Per anni Alibaba ha adottato l’approccio customary del settore: creare un modello linguistico, quindi collegare un codificatore di visione per creare una variante VL separata. Qwen3.5 abbandona completamente questo modello. Il modello viene addestrato da zero su testo, immagini e video contemporaneamente, il che significa che il ragionamento visivo è intrecciato nelle rappresentazioni principali del modello anziché innestato.

Questo è importante nella pratica. I modelli multimodali nativi tendono a sovraperformare le loro controparti basate su adattatore su attività che richiedono un ragionamento rigoroso su testo e immagine: si pensi all’analisi di un diagramma tecnico insieme alla sua documentazione, all’elaborazione di screenshot dell’interfaccia utente per attività di agenti o all’estrazione di dati strutturati da format visivi complessi. Su MathVista, il modello ottiene un punteggio di 90,3; su MMMU, 85.0. È dietro a Gemini 3 su diversi benchmark specifici per la visione, ma supera Claude Opus 4.5 su attività multimodali e registra numeri competitivi rispetto a GPT-5.2, il tutto portando con sé una frazione del conteggio dei parametri.

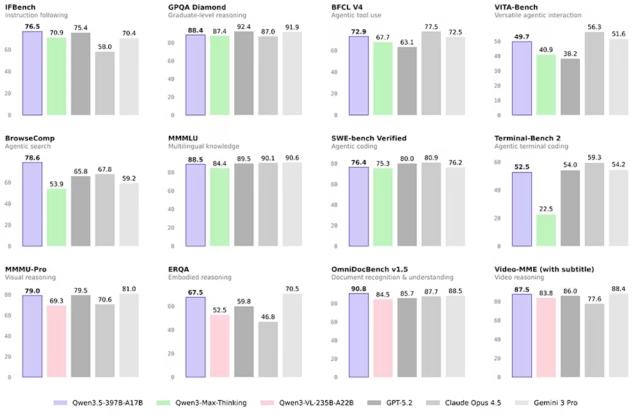

Le prestazioni di riferimento di Qwen3.5 rispetto ai modelli proprietari più grandi sono il numero che guiderà le conversazioni aziendali.

Secondo le valutazioni pubblicate da Alibaba, il modello 397B-A17B supera Qwen3-Max, un modello con oltre un trilione di parametri, in molteplici attività di ragionamento e codifica.

Dichiara inoltre risultati competitivi rispetto a GPT-5.2, Claude Opus 4.5 e Gemini 3 Professional sul ragionamento generale e sui benchmark di codifica.

Copertura linguistica ed efficienza del tokenizzatore

Un dettaglio sottovalutato della versione Qwen3.5 è la sua portata multilingue ampliata. Il vocabolario del modello è cresciuto fino a 250.000 token, rispetto ai 150.000 delle precedenti generazioni di Qwen e ora paragonabile al tokenizzatore da ~256.000 di Google. Il supporto linguistico si espande da 119 lingue in Qwen 3 a 201 lingue e dialetti.

L’aggiornamento del tokenizzatore ha implicazioni dirette sui costi per le distribuzioni globali. Vocabolari più ampi codificano le scritture non latine (arabo, tailandese, coreano, giapponese, hindi e altre) in modo più efficiente, riducendo il numero di token del 15-40% a seconda della lingua. Per le organizzazioni IT che utilizzano l’intelligenza artificiale su larga scala su basi di utenti multilingue, questo non è un dettaglio accademico. Ciò si traduce direttamente in costi di inferenza inferiori e tempi di risposta più rapidi.

Funzionalità agenti e integrazione OpenClaw

Alibaba sta posizionando Qwen3.5 esplicitamente come un modello advert agenti, progettato non solo per rispondere alle domande ma per intraprendere azioni autonome in più fasi per conto di utenti e sistemi. L’azienda ha Qwen Code open supply, un’interfaccia a riga di comando che consente agli sviluppatori di delegare complesse attività di codifica al modello in linguaggio naturale, più o meno analogo al Claude Code di Anthropic.

Il rilascio evidenzia inoltre la compatibilità con OpenClaw, il framework di agenti open supply che quest’anno ha registrato un’impennata nell’adozione da parte degli sviluppatori. Con 15.000 distinti ambienti di formazione con apprendimento per rinforzo utilizzati per affinare il ragionamento del modello e l’esecuzione delle attività, il group Qwen ha fatto una scommessa deliberata sulla formazione basata su RL per migliorare le prestazioni pratiche degli agenti, una tendenza coerente con ciò che MiniMax ha dimostrato con M2.5.

La variante ospitata Qwen3.5-Plus consente anche modalità di inferenza adattiva: una modalità veloce per applicazioni sensibili alla latenza, una modalità di pensiero che consente un ragionamento con catena di pensiero estesa per attività complesse e una modalità automatica (adattiva) che seleziona dinamicamente. Questa flessibilità è importante per le implementazioni aziendali in cui potrebbe essere necessario che lo stesso modello supporti sia le interazioni in tempo reale con i clienti che i flussi di lavoro analitici approfonditi.

Realtà dell’implementazione: cosa devono effettivamente sapere i group IT

L’esecuzione interna dei pesi aperti di Qwen3.5 richiede {hardware} serio. Mentre una versione quantizzata richiede circa 256 GB di RAM e realisticamente 512 GB per un headroom confortevole. Questo non è un modello per una workstation o un modesto server locale. Ciò per cui è adatto è un nodo GPU, una configurazione che molte aziende già utilizzano per carichi di lavoro di inferenza e che ora offre un’alternativa convincente alle distribuzioni dipendenti dalle API.

Tutti i modelli Qwen 3.5 a peso aperto sono rilasciati con la licenza Apache 2.0. Questa è una distinzione significativa rispetto ai modelli con licenze personalizzate o limitate: Apache 2.0 consente l’uso commerciale, la modifica e la ridistribuzione senza royalties, senza vincoli significativi. Per i group legali e di procurement che valutano modelli aperti, questo approccio pulito alle licenze semplifica notevolmente la conversazione.

Cosa verrà dopo

Alibaba ha confermato che questa è la prima versione della famiglia Qwen3.5, non il lancio completo. Sulla base del modello di Qwen3 – che prevedeva modelli fino a 600 milioni di parametri – l’industria prevede che nelle prossime settimane e mesi seguiranno modelli distillati più piccoli e densi e ulteriori configurazioni MoE. Il modello Qwen3-Subsequent 80B dello scorso settembre è stato ampiamente considerato sottoutilizzato, suggerendo che una variante 3.5 su quella scala è una probabile versione a breve termine.

Per i decisori IT, la traiettoria è chiara. Alibaba ha dimostrato che i modelli a peso aperto alla frontiera non sono più un compromesso. Qwen3.5 è una vera e propria opzione di procurement per i group che desiderano un ragionamento di prima classe, funzionalità multimodali native e una finestra di contesto dei token da 1 milione, senza vincolarsi a un’API proprietaria. La domanda successiva non è se questa famiglia di modelli sia sufficientemente capace. Dipende se la tua infrastruttura e il tuo group sono pronti a trarne vantaggio.

Qwen 3.5 lo è disponibile ora su Hugging Face con l’ID modello Qwen/Qwen3.5-397B-A17B. La variante Qwen3.5-Plus ospitata è disponibile tramite Studio del modello cloud di Alibaba. Qwen Chatta su chat.qwen.ai offre accesso pubblico gratuito per la valutazione.