Quando le aziende perfezionano i LLM per nuove attività, rischiano di infrangere tutto ciò che i modelli già conoscono. Ciò costringe le aziende a mantenere modelli separati per ogni competenza.

I ricercatori del MIT, dell’Unbelievable AI Lab e dell’ETH di Zurigo hanno sviluppato una nuova tecnica che consente a grandi modelli linguistici di apprendere nuove abilità e conoscenze senza dimenticare le loro capacità passate.

La loro tecnica, chiamata messa a punto dell’autodistillazione (SDFT), consente ai modelli di apprendere direttamente dalle dimostrazioni e dai propri esperimenti sfruttando le capacità di apprendimento intrinseche dei moderni LLM. Gli esperimenti mostrano che SDFT supera costantemente le tradizionali prestazioni di regolazione wonderful supervisionata (SFT) affrontando i limiti degli algoritmi di apprendimento per rinforzo.

Per le applicazioni aziendali, il metodo consente a un singolo modello di accumulare più competenze nel tempo senza subire una regressione delle prestazioni nelle attività precedenti. Ciò offre un potenziale percorso per la creazione di agenti IA in grado di adattarsi advert ambienti aziendali dinamici, acquisendo nuove conoscenze e competenze proprietarie secondo necessità senza richiedere costosi cicli di riqualificazione o perdere le loro capacità di ragionamento generale.

La sfida dell’apprendimento continuo

Una volta addestrato e distribuito, un LLM rimane statico. Non aggiorna i suoi parametri per acquisire nuove competenze, interiorizzare nuove conoscenze o migliorare dall’esperienza. Per costruire un’intelligenza artificiale veramente adattiva, l’industria deve risolvere “apprendimento continuo“, consentendo ai sistemi di accumulare conoscenza proprio come fanno gli esseri umani durante la loro carriera.

Il modo più efficace per l’apprendimento dei modelli è attraverso l’”apprendimento basato sulle politiche”. In questo approccio, il modello apprende dai dati che esso stesso genera permettendogli di correggere i propri errori e processi di ragionamento. Ciò è in contrasto con l’apprendimento semplicemente imitando set di dati statici. Senza l’apprendimento basato sulle politiche, i modelli sono inclini a “dimenticanza catastrofica,” un fenomeno in cui l’apprendimento di un nuovo compito fa sì che il modello perda la conoscenza passata e la capacità di eseguire compiti precedenti.

Tuttavia, l’apprendimento in linea con le politiche in genere richiede apprendimento per rinforzo (RL), che dipende da una funzione di ricompensa esplicita per valutare gli output del modello. Funziona bene per problemi con risultati chiari, come matematica e programmazione. Ma in molti scenari aziendali reali (advert esempio, scrivere un transient legale o riassumere una riunione), definire una funzione matematica di ricompensa è difficile o impossibile.

I metodi RL spesso falliscono anche quando si tenta di insegnare a un modello informazioni completamente nuove, come un protocollo aziendale specifico o una nuova linea di prodotti. Come ha detto a VentureBeat Idan Shenfeld, dottorando al MIT e coautore dell’articolo, “Non importa quante volte il modello di base ci prova, non può generare risposte corrette per un argomento di cui non ha alcuna conoscenza”, il che significa che non riceve mai un segnale positivo da cui imparare.

L’alternativa normal è il wonderful tuning supervisionato (SFT), in cui il modello viene addestrato su un set di dati fisso di dimostrazioni di esperti. Anche se la SFT fornisce una chiara verità, è intrinsecamente “fuori coverage”. Poiché il modello si limita a imitare i dati anziché imparare dai propri tentativi, spesso non riesce a generalizzare advert esempi fuori distribuzione e soffre pesantemente di un dimenticatoio catastrofico.

SDFT cerca di colmare questa lacuna: consentendo i vantaggi dell’apprendimento basato sulle politiche utilizzando solo dimostrazioni preregistrate, senza bisogno di una funzione di ricompensa.

Come funziona l’SDFT

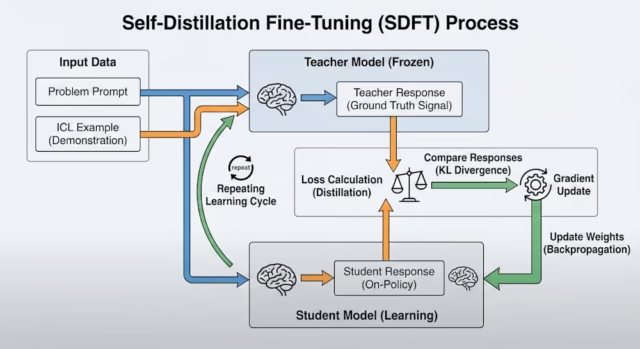

SDFT risolve questo problema utilizzando la “distillazione”, un processo in cui uno studente modello impara a imitare un insegnante. L’intuizione dei ricercatori è stata quella di utilizzare le capacità di “apprendimento nel contesto” (ICL) proprie del modello per creare un ciclo di suggestions all’interno di un singolo modello.

L’apprendimento in contesto è il fenomeno in cui fornisci al LLM un compito difficile e una o più dimostrazioni di come vengono risolti problemi simili. I LLM più avanzati sono progettati per risolvere nuovi problemi con esempi ICL, senza alcun aggiornamento dei parametri.

Durante il ciclo di formazione, SDFT utilizza il modello in due ruoli.

L’insegnante: Alla question viene fornita una versione congelata del modello insieme alle dimostrazioni degli esperti. Utilizzando ICL, l’insegnante deduce la risposta corretta e il ragionamento logico necessario per raggiungerla.

Lo studente: Questa versione vede solo la question, simulando uno state of affairs di distribuzione reale in cui non è disponibile alcuna chiave di risposta.

Quando lo studente genera una risposta, l’insegnante, che ha accesso alle dimostrazioni degli esperti, fornisce un suggestions. Lo studente quindi aggiorna i suoi parametri per allinearli più vicino alla distribuzione dell’insegnante.

Questo processo crea di fatto un ciclo di apprendimento in linea con le politiche combinando elementi di SFT e RL. La supervisione non proviene da un set di dati statico, ma dall’interazione e dai risultati propri del modello. Consente al modello di correggere le proprie traiettorie di ragionamento senza richiedere un segnale di ricompensa esterno. Questo processo funziona anche per nuove conoscenze che RL perderebbe.

SDFT in azione

Per convalidare l’approccio, i ricercatori hanno testato SDFT utilizzando il peso aperto Modello Qwen 2.5 su tre competenze complesse di livello aziendale: domande e risposte scientifiche, utilizzo di strumenti software program e ragionamento medico.

I risultati hanno mostrato che SDFT ha appreso nuovi compiti in modo più efficace rispetto ai metodi normal. Sul benchmark Science Q&A, il modello SDFT ha raggiunto un’accuratezza del 70,2%, rispetto al 66,2% dell’approccio SFT normal.

Più importante per l’adozione aziendale è l’impatto sull’oblio catastrofico. Quando il modello SFT normal ha imparato il compito scientifico, la sua capacità di rispondere a domande generali (come la logica o le self-discipline umanistiche) è crollata. Al contrario, il modello SDFT ha migliorato il compito scientifico mantenendo stabile il punteggio dei “Compiti precedenti” al 64,5%. Questa stabilità suggerisce che le aziende potrebbero specializzare modelli per dipartimenti specifici (advert esempio, risorse umane o legale) senza degradare il buon senso o le capacità di ragionamento di base del modello.

Il group ha anche simulato uno state of affairs di iniezione di conoscenza, creando un set di dati di “disastri naturali del 2025” fittizi per insegnare al modello nuovi fatti. Hanno testato il modello su domande di ragionamento indiretto, come “Date le inondazioni del 2025, quali paesi probabilmente avevano bisogno di aiuti umanitari?”

La SFT normal ha prodotto un modello che memorizzava i fatti ma faticava a usarli in scenari di ragionamento. Il modello SDFT, avendo interiorizzato la logica durante la formazione, ha ottenuto il 98% sulle stesse domande.

Infine, i ricercatori hanno condotto un esperimento di apprendimento sequenziale, addestrando il modello sulla scienza, sull’uso degli strumenti e sui compiti medici uno dopo l’altro. Mentre le prestazioni del modello normal oscillavano, perdendo le competenze precedenti mentre ne apprendevano di nuove, il modello SDFT ha accumulato con successo tutte e tre le competenze senza regressione.

Questa funzionalità risolve uno dei principali punti critici per le aziende che attualmente gestiscono “zoo modello” di adattatori separati per attività various.

“Offriamo la possibilità di mantenere un unico modello per tutte le esigenze dell’azienda”, ha affermato Shenfeld. Questo consolidamento “può portare a una sostanziale riduzione dei costi di inferenza” perché le organizzazioni non hanno bisogno di ospitare più modelli contemporaneamente.

Limitazioni e disponibilità dell’SDFT

Il codice per SDFT è disponibile su GitHub e pronto per essere integrato nei flussi di lavoro di formazione del modello esistenti.

“La pipeline SDFT è più simile alla pipeline RL in quanto richiede la generazione di risposte on-line durante la formazione”, ha affermato Shenfeld. Stanno lavorando con Hugging Face per integrare SDFT in quest’ultimo Apprendimento per rinforzo del trasformatore (TRL), ha aggiunto, sottolineando che una richiesta pull è già aperta per gli sviluppatori che desiderano testare l’integrazione.

Per i group che prendono in considerazione SDFT, i compromessi pratici si riducono alle dimensioni del modello e al calcolo. La tecnica richiede modelli con un apprendimento nel contesto sufficientemente forte da agire come insegnanti di se stessi: attualmente circa 4 miliardi di parametri con architetture più recenti come Qwen 3, anche se Shenfeld prevede che modelli da 1 miliardo di parametri funzioneranno presto. Richiede circa 2,5 volte il calcolo di un wonderful tuning normal, ma è più adatto per le organizzazioni che necessitano di un unico modello per accumulare più competenze nel tempo, in particolare nei settori in cui definire una funzione di ricompensa per l’apprendimento per rinforzo è difficile o impossibile.

Sebbene efficace, il metodo presenta dei compromessi computazionali. SDFT è circa quattro volte più lento e richiede 2,5 volte più potenza di calcolo (FLOP) rispetto alla regolazione wonderful normal perché il modello deve generare attivamente le proprie risposte (“laminazioni”) durante la formazione per confrontarle con quelle dell’insegnante. Tuttavia, i ricercatori sottolineano che, poiché il modello conserva meglio la conoscenza, le organizzazioni possono evitare i costosi processi di riqualificazione in più fasi spesso necessari per riparare modelli che soffrono di dimenticanze catastrofiche.

La tecnica si basa anche sul fatto che il modello sottostante sia abbastanza grande da beneficiare dell’apprendimento nel contesto. L’articolo rileva che i modelli più piccoli (advert esempio, 3 miliardi di parametri) inizialmente hanno avuto difficoltà perché mancavano di “intelligenza” per agire come insegnanti di se stessi.

Tuttavia, Shenfeld ha affermato che il rapido miglioramento dei piccoli modelli sta cambiando questa dinamica. “I modelli Qwen 2.5 3B erano troppo deboli, ma in alcuni esperimenti che facciamo attualmente, abbiamo scoperto che il modello Qwen 3 4B è abbastanza forte”, ha detto. “Vedo un futuro in cui anche i modelli 1B avranno capacità ICL sufficientemente buone da supportare SDFT.”

In definitiva, l’obiettivo è quello di andare oltre le istantanee statiche verso sistemi che migliorano attraverso l’uso.

“L’apprendimento permanente, insieme alla capacità di estrarre segnali di apprendimento da interazioni non strutturate degli utenti… porterà modelli che continuano a migliorare con il tempo”, ha affermato Shenfeld.

“Pensate al fatto che già la maggior parte dell’elaborazione in tutto il mondo viene utilizzata per l’inferenza invece che per l’addestramento. Dobbiamo trovare il modo di sfruttare questa elaborazione per migliorare i nostri modelli.”