Con l’esplosione di dimensioni dell’ecosistema di strumenti e framework agentici, orientarsi tra le numerose opzioni per la creazione di sistemi di intelligenza artificiale sta diventando sempre più difficile, lasciando gli sviluppatori confusi e paralizzati nella scelta degli strumenti e dei modelli giusti per le loro applicazioni.

Nell’a nuovo studioricercatori provenienti da più istituzioni presentano un quadro completo per districare questa complessa rete. Classificano i framework degli agenti in base alla loro space di interesse e ai compromessi, fornendo una guida pratica agli sviluppatori per scegliere gli strumenti e le strategie giuste per le loro applicazioni.

Per i crew aziendali, questo trasforma l’intelligenza artificiale degli agenti da un problema di selezione del modello in una decisione architetturale su dove spendere il price range per la formazione, quanta modularità preservare e quali compromessi sono disposti a fare tra costi, flessibilità e rischio.

Adattamento dell’agente e dello strumento

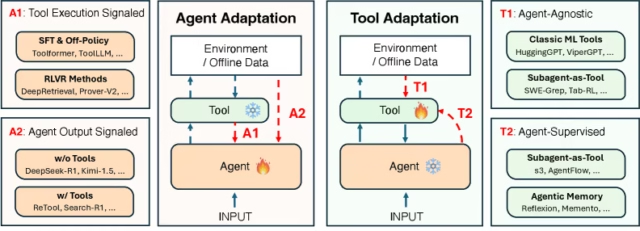

I ricercatori dividono il paesaggio in due dimensioni principali: adattamento dell’agente E adattamento dello strumento.

L’adattamento degli agenti implica la modifica del modello di base che sta alla base del sistema degli agenti. Ciò viene fatto aggiornando i parametri o le politiche interne dell’agente attraverso metodi come la messa a punto o l’apprendimento per rinforzo per allinearsi meglio con compiti specifici.

L’adattamento dello strumento, d’altro canto, sposta l’attenzione sull’ambiente che circonda l’agente. Invece di riqualificare il modello di base ampio e costoso, gli sviluppatori ottimizzano gli strumenti esterni come search retriever, moduli di memoria o agenti secondari. In questa strategia, l’agente principale rimane “congelato” (invariato). Questo approccio consente al sistema di evolversi senza l’enorme costo computazionale della riqualificazione del modello principale.

Lo studio li suddivide ulteriormente in quattro strategie distinte:

A1: Esecuzione dell’utensile segnalata: In questa strategia, l’agente impara facendo. È ottimizzato utilizzando suggestions verificabili direttamente dall’esecuzione di uno strumento, advert esempio un compilatore di codice che interagisce con uno script o un database che restituisce risultati di ricerca. Questo insegna all’agente i “meccanici” per utilizzare correttamente uno strumento.

Un ottimo esempio è DeepSeek-R1in cui il modello è stato addestrato tramite l’apprendimento per rinforzo con ricompense verificabili per generare codice che viene eseguito con successo in una sandbox. Il segnale di suggestions è binario e oggettivo (il codice è stato eseguito o si è bloccato?). Questo metodo sviluppa forti competenze di basso livello in domini stabili e verificabili come la codifica o SQL.

A2: Uscita agente segnalata: Qui l’agente viene ottimizzato in base alla qualità della sua risposta finale, indipendentemente dai passaggi intermedi e dal numero di chiamate allo strumento effettuate. Questo insegna all’agente come orchestrare vari strumenti per raggiungere una conclusione corretta.

Un esempio è Cerca-R1un agente che esegue il recupero in più fasi per rispondere alle domande. Il modello riceve una ricompensa solo se la risposta finale è corretta, costringendolo implicitamente advert apprendere migliori strategie di ricerca e ragionamento per massimizzare story ricompensa. A2 è ideale per l’orchestrazione a livello di sistema, consentendo agli agenti di gestire flussi di lavoro complessi.

T1: indipendente dall’agente: In questa categoria, gli strumenti vengono addestrati in modo indipendente su dati ampi e quindi “collegati” a un agente congelato. Pensa ai classici dense retriever utilizzati nei sistemi RAG. Un modello retriever commonplace viene addestrato su dati di ricerca generici. Un potente LLM congelato può utilizzare questo retriever per trovare informazioni, anche se il retriever non è stato progettato specificamente per quel LLM.

T2: Supervisionato dall’agente: Questa strategia prevede strumenti di formazione specifici per servire un agente congelato. Il segnale di supervisione proviene dall’output stesso dell’agente, creando una relazione simbiotica in cui lo strumento impara a fornire esattamente ciò di cui l’agente ha bisogno.

Advert esempio, il quadro s3 addestra un piccolo modello di “ricercatore” per recuperare documenti. Questo piccolo modello viene premiato in base alla capacità di un “ragionatore” congelato (un grande LLM) di rispondere correttamente alla domanda utilizzando tali documenti. Lo strumento si adatta efficacemente per colmare le lacune di conoscenza specifiche dell’agente principale.

I sistemi di intelligenza artificiale complessi potrebbero utilizzare una combinazione di questi paradigmi di adattamento. Advert esempio, un sistema di ricerca approfondita potrebbe utilizzare strumenti di recupero in stile T1 (dense retriever pre-addestrati), agenti di ricerca adattivi in stile T2 (addestrati tramite suggestions LLM congelato) e agenti di ragionamento in stile A1 (perfezionati con suggestions di esecuzione) in un sistema orchestrato più ampio.

I costi nascosti e i compromessi

Per i decisori aziendali, la scelta tra queste strategie spesso dipende da tre fattori: costo, generalizzazione e modularità.

Costo vs flessibilità: L’adattamento dell’agente (A1/A2) offre la massima flessibilità perché stai ricablando il cervello dell’agente. Tuttavia, i costi sono elevati. Advert esempio, Search-R1 (un sistema A2) ha richiesto una formazione su 170.000 esempi per internalizzare le capacità di ricerca. Ciò richiede enormi quantità di calcolo e set di dati specializzati. D’altra parte, i modelli possono essere molto più efficienti al momento dell’inferenza perché sono molto più piccoli dei modelli generalisti.

Al contrario, l’adattamento dell’utensile (T1/T2) è molto più efficiente. Il sistema s3 (T2) ha addestrato un ricercatore leggero utilizzando solo 2.400 esempi (circa 70 volte meno dati rispetto a Search-R1) ottenendo prestazioni comparabili. Ottimizzando l’ecosistema anziché l’agente, le aziende possono ottenere prestazioni elevate a un costo inferiore. Tuttavia, ciò comporta un tempo di inferenza dei costi generali poiché s3 richiede il coordinamento con un modello più grande.

Generalizzazione: I metodi A1 e A2 rischiano il “overfitting”, in cui un agente diventa così specializzato in un compito da perdere capacità generali. Lo studio ha rilevato che, sebbene Search-R1 eccellesse nei suoi compiti di formazione, faticava con il QA medico specializzato, ottenendo solo il 71,8% di precisione. Questo non è un problema quando l’agente è progettato per eseguire una serie di attività molto specifiche.

Al contrario, il sistema s3 (T2), che utilizzava un agente congelato per uso generale assistito da uno strumento addestrato, si è generalizzato meglio, raggiungendo una precisione del 76,6% sugli stessi compiti medici. L’agente congelato ha mantenuto la sua vasta conoscenza del mondo, mentre lo strumento ha gestito i meccanismi di recupero specifici. Tuttavia, i sistemi T1/T2 si basano sulla conoscenza dell’agente congelato e se il modello sottostante non è in grado di gestire l’attività specifica, saranno inutili.

Modularità: Le strategie T1/T2 consentono l'”scorching swapping”. Puoi aggiornare un modulo di memoria o un ricercatore senza toccare il motore di ragionamento principale. Per esempio, Ricordo ottimizza un modulo di memoria per recuperare casi passati; se i requisiti cambiano, aggiorni il modulo, non il pianificatore.

I sistemi A1 e A2 sono monolitici. Insegnare a un agente una nuova abilità (come la codifica) tramite il perfezionamento può causare un “dimenticamento catastrofico”, in cui si degradano le abilità precedentemente apprese (come la matematica) perché i suoi pesi interni vengono sovrascritti.

Un quadro strategico per l’adozione aziendale

Sulla base dello studio, gli sviluppatori dovrebbero considerare queste strategie come una scala progressiva, passando da soluzioni modulari a basso rischio a una personalizzazione advert alta risorsa.

Inizia con T1 (strumenti indipendenti dall’agente): Equipaggia un modello congelato e potente (come Gemini o Claude) con strumenti commonplace come un denso retriever o un Connettore MCP. Ciò non richiede alcuna formazione ed è perfetto per la prototipazione e le applicazioni generali. È il frutto a portata di mano che può portarti molto lontano per la maggior parte dei compiti.

Passa a T2 (strumenti supervisionati dall’agente): Se l’agente ha difficoltà a utilizzare strumenti generici, non riqualificare il modello principale. Invece, addestra un piccolo agente secondario specializzato (come un ricercatore o un gestore della memoria) a filtrare e formattare i dati esattamente come piace all’agente principale. Si tratta di un sistema altamente efficiente in termini di dati e adatto a dati e applicazioni aziendali proprietari con volumi elevati e sensibili ai costi.

Utilizzare A1 (esecuzione dello strumento segnalata) per la specializzazione: Se l’agente fallisce sostanzialmente nei compiti tecnici (advert esempio, scrivendo codice non funzionale o chiamate API errate), è necessario riprogrammare la sua comprensione della “meccanica” dello strumento. A1 è la soluzione migliore per creare specialisti in domini verificabili come SQL o Python o i tuoi strumenti proprietari. Advert esempio, puoi ottimizzare un modello di piccole dimensioni per il tuo set di strumenti specifico e quindi utilizzarlo come plug-in T1 per un modello generalista.

Riserva A2 (uscita dell’agente segnalata) come “opzione nucleare”: Forma un agente monolitico end-to-end solo se ne hai bisogno per interiorizzare strategie complesse e autocorrezioni. Si tratta di un utilizzo intensivo delle risorse e raramente necessario per le applicazioni aziendali commonplace. In realtà, raramente hai bisogno di essere coinvolto nell’addestramento del tuo modello.

Man mano che il panorama dell’intelligenza artificiale matura, l’attenzione si sta spostando dalla costruzione di un modello gigante e perfetto alla costruzione di un ecosistema intelligente di strumenti specializzati attorno a un nucleo stabile. Per la maggior parte delle aziende, il percorso più efficace verso l’intelligenza artificiale degli agenti non è costruire un cervello più grande, ma fornire al cervello strumenti migliori.