Startup cinese dedicata all’intelligenza artificiale MiniMaxcon sede a Shanghai, ha inviato oggi un’onda d’urto nel settore dell’intelligenza artificiale con il rilascio del suo nuovo Modello linguistico M2.5 in due varianti, che promettono di rendere l’intelligenza artificiale di fascia alta così economica da farti smettere di preoccuparti del conto.

Si cube anche che sia “fonte aperta,” anche se i pesi (impostazioni) e il codice non sono stati ancora pubblicati, né l’esatto tipo di licenza o i termini. Ma questo è quasi fuori questione dato quanto MiniMax lo offre a buon mercato attraverso la sua API e quelle dei associate.

Negli ultimi anni, utilizzare l’intelligenza artificiale più potente del mondo è stato come assumere un consulente costoso: period geniale, ma guardavi costantemente l’orologio (e il conteggio dei token). M2.5 cambia i conti, riducendo il costo della frontiera fino al 95%.

Fornendo prestazioni che rivaleggiano con i modelli di alto livello di Google e Anthropic a una frazione del costo, in particolare nell’utilizzo di strumenti agentici per attività aziendali, tra cui creazione di file Microsoft Phrase, Excel e PowerPointMiniMax scommette che il futuro non dipende solo da quanto un modello sia intelligente, ma da quanto spesso puoi permetterti di usarlo.

Infatti, a tal advantageous, MiniMax afferma di aver collaborato “con professionisti senior in settori quali la finanza, il diritto e le scienze sociali” per garantire che il modello potesse svolgere un lavoro reale secondo le loro specifiche e commonplace.

Questa versione è importante perché segnala il passaggio dall’IA come “chatbot” all’IA come “lavoratore”. Quando l’intelligenza diventa “troppo economica per essere misurata”, gli sviluppatori smettono di creare semplici strumenti di domande e risposte e iniziano a creare “agenti”, software program in grado di trascorrere ore in modo autonomo a codificare, ricercare e organizzare progetti complessi senza spendere una fortuna.

In effetti, MiniMax ha già implementato questo modello nelle proprie operazioni. Attualmente, Il 30% di tutte le attività presso il quartier generale di MiniMax vengono completate da M2.5e uno sconcertante L’80% del codice appena impegnato è generato da M2.5!

Come scrive il staff MiniMax nel publish sul weblog di rilascio, “crediamo che M2.5 offra possibilità praticamente illimitate per lo sviluppo e il funzionamento degli agenti nell’economia”.

Tecnologia: scarsa potenza e la svolta CISPO

Il segreto dell’efficienza di M2.5 risiede nella sua architettura Combination of Consultants (MoE). Invece di eseguire tutti i suoi 230 miliardi di parametri per ogni singola parola che genera, il modello ne “attiva” solo 10 miliardi. Ciò gli consente di mantenere la profondità di ragionamento di un modello massiccio mentre si muove con l’agilità di uno molto più piccolo.

Per addestrare questo sistema complesso, MiniMax ha sviluppato un framework proprietario di Reinforcement Studying (RL) chiamato Forge. Ingegnere MiniMax Canzone dell’olivo dichiarato sul Podcast di ThursdAI su YouTube che questa tecnica è stata determinante per ridimensionare le prestazioni anche utilizzando un numero relativamente piccolo di parametri e che il modello è stato addestrato per un periodo di due mesi.

Forge è progettato per aiutare il modello advert apprendere dagli “ambienti del mondo reale”, consentendo essenzialmente all’intelligenza artificiale di esercitarsi nella codifica e nell’utilizzo di strumenti in migliaia di spazi di lavoro simulati.

“Ciò che abbiamo capito è che c’è molto potenziale con un piccolo modello come questo se addestriamo l’apprendimento per rinforzo su di esso con una grande quantità di ambienti e agenti”, ha detto Music. “Ma non è una cosa molto facile da fare”, aggiungendo che è ciò su cui hanno dedicato “molto tempo”.

Per mantenere stabile il modello durante questa intensa formazione, hanno utilizzato un approccio matematico chiamato CISPO (Clipping Significance Sampling Coverage Optimization) e hanno condiviso la system sul loro weblog.

Questa system garantisce che il modello non venga corretto eccessivamente durante l’addestramento, consentendogli di sviluppare quella che MiniMax chiama una “mentalità da architetto”. Invece di passare direttamente alla scrittura del codice, M2.5 ha imparato a pianificare prima in modo proattivo la struttura, le funzionalità e l’interfaccia di un progetto.

Benchmark all’avanguardia (e vicini).

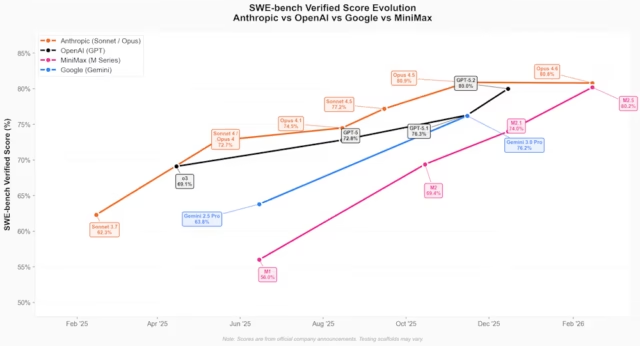

I risultati di questa architettura si riflettono nelle ultime classifiche del settore. M2.5 non è solo migliorato; è balzato al livello più alto dei modelli di codifica, avvicinandosi all’ultimo modello di Anthropic, Claude Opus 4.6, rilasciato solo una settimana fa, e dimostrando che le aziende cinesi sono ormai a pochi giorni dal raggiungere laboratori statunitensi con risorse molto migliori (in termini di GPU).

Ecco alcuni dei nuovi punti salienti del benchmark MiniMax M2.5:

-

Verificato dal banco SWE: 80,2% – Corrisponde alle velocità di Claude Opus 4.6

-

SfogliaComp: 76,3%: Ricerca e utilizzo di strumenti chief del settore.

-

Panca Multi-SWE: 51,3% — SOTA nella codifica multilingue

-

BFCL (chiamata utensile): 76,8%: flussi di lavoro agentici advert alta precisione.

Sul podcast ThursdAI, il conduttore Alex Volkov ha sottolineato che MiniMax M2.5 funziona in modo estremamente rapido e quindi utilizza meno token per completare le attività, nell’ordine di $ 0,15 per attività rispetto ai $ 3,00 di Claude Opus 4.6.

Rompere la barriera dei costi

MiniMax offre due versioni del modello attraverso la sua API, entrambe focalizzate sull’uso di produzione advert alto quantity:

-

M2.5-Fulmine: Ottimizzato per la velocità, offrendo 100 token al secondo. Il costo è di $ 0,30 per 1 milione di token di enter e $ 2,40 per 1 milione di token di output.

-

M2.5 commonplace: Ottimizzato per i costi, funziona a 50 token al secondo. Costa la metà della versione Lightning ($ 0,15 per 1 milione di token di enter / $ 1,20 per 1 milione di token di output).

In parole povere: MiniMax afferma che è possibile gestire quattro “agenti” (lavoratori AI) ininterrottamente per un anno intero per circa $ 10.000.

Per gli utenti aziendali, questo prezzo è compreso tra 1/10 e 1/20 del costo dei modelli proprietari concorrenti come GPT-5 o Claude 4.6 Opus.

|

Modello |

Ingresso |

Produzione |

Costo totale |

Fonte |

|

Qwen3Turbo |

$ 0,05 |

$ 0,20 |

$ 0,25 |

|

|

chat-deepseek (V3.2-Exp) |

$ 0,28 |

$ 0,42 |

$ 0,70 |

|

|

ragionatore di ricerca profonda (V3.2-Exp) |

$ 0,28 |

$ 0,42 |

$ 0,70 |

|

|

Grok 4.1 Veloce (ragionamento) |

$ 0,20 |

$ 0,50 |

$ 0,70 |

|

|

Grok 4.1 Veloce (non ragionante) |

$ 0,20 |

$ 0,50 |

$ 0,70 |

|

|

MiniMax M2.5 |

$ 0,15 |

$ 1,20 |

$ 1,35 |

|

|

MiniMax M2.5-Lightning |

$ 0,30 |

$ 2,40 |

$ 2,70 |

|

|

Anteprima Flash di Gemini 3 |

$ 0,50 |

$ 3,00 |

$ 3,50 |

|

|

Kimi-k2.5 |

$ 0,60 |

$ 3,00 |

$ 3,60 |

|

|

GLM-5 |

$ 1,00 |

$ 3,20 |

$ 4,20 |

|

|

ERNI 5.0 |

$ 0,85 |

$ 3,40 |

$ 4,25 |

|

|

ClaudeHaiku4.5 |

$ 1,00 |

$ 5,00 |

$ 6,00 |

|

|

Qwen3-Max (23/01/2026) |

$ 1,20 |

$ 6,00 |

$ 7,20 |

|

|

Gemini 3 Professional (≤200.000) |

$ 2,00 |

$ 12,00 |

$ 14,00 |

|

|

GPT-5.2 |

$ 1,75 |

$ 14,00 |

$ 15,75 |

|

|

Claude Sonetto 4.5 |

$ 3,00 |

$ 15,00 |

$ 18,00 |

|

|

Gemini 3 Professional (>200K) |

$ 4,00 |

$ 18,00 |

$ 22,00 |

|

|

Claude Opus 4.6 |

$ 5,00 |

$ 25,00 |

$ 30,00 |

|

|

GPT-5.2Pro |

$ 21,00 |

$ 168,00 |

$ 189,00 |

Implicazioni strategiche per imprese e chief

Per i chief tecnici, M2.5 rappresenta molto più di una semplice API più economica. Cambia il playbook operativo per le imprese in questo momento.

La pressione per “ottimizzare” le richieste di risparmio è scomparsa. Ora puoi implementare modelli advert alto contesto e ragionamento per attività di routine che in precedenza erano proibitive in termini di costi.

Il miglioramento della velocità del 37% nel completamento delle attività end-to-end significa che le pipeline “agentiche” apprezzate dagli orchestratori di intelligenza artificiale – dove i modelli comunicano con altri modelli – finalmente si muovono abbastanza velocemente per le applicazioni utente in tempo reale.

Inoltre, gli alti punteggi di M2.5 nella modellistica finanziaria (74,4% su MEWC) suggeriscono che può gestire la “conoscenza tacita” di settori specializzati come il diritto e la finanza con una supervisione minima.

Poiché M2.5 è posizionato come modello open supply, le organizzazioni possono potenzialmente eseguire controlli intensivi e automatizzati del codice su una scala che prima period impossibile senza un massiccio intervento umano, il tutto mantenendo un migliore controllo sulla privateness dei dati, ma fino a quando non verranno pubblicati i termini e i pesi della licenza, questo rimarrà solo un soprannome.

MiniMax M2.5 è un segnale che la frontiera dell’intelligenza artificiale non riguarda più solo chi può costruire il cervello più grande, ma chi può rendere quel cervello il lavoratore più utile e conveniente nella stanza.