La vera portata del problema dei deepfake di Grok sta diventando sempre più chiara mentre la piattaforma di social media e la sua startup di intelligenza artificiale xAI affrontano indagini in corso sulle barriere di sicurezza del chatbot.

Secondo a rapporto dal Centro per la lotta all’odio digitale (CCDH) e da un’associazione indagine dal New York InstancesGrok è stato in grado di produrre circa 3 milioni di immagini sessualizzate, di cui 23.000 che sembrano raffigurare bambini in un periodo di 11 giorni tra il 29 dicembre e l’8 gennaio, nel contesto della presunta repressione di xAI sui deepfake “spogliarsi.” Il CCDH ha testato un campione di risposte dallo strumento di modifica con un clic di Grok, ancora disponibile per gli utenti X, e ha calcolato che più della metà delle risposte del chatbot includevano contenuti sessualizzati.

Divieto di approvazione: le nazioni stanno valutando la possibilità di bloccare il chatbot AI per contenuti sessuali non consensuali

IL New York Instances Il rapporto ha rilevato che circa 1,8 milioni dei 4,4 milioni di immagini di Grok erano di natura sessuale, alcune raffiguranti influencer e celebrità ben noti. La pubblicazione collega anche un forte aumento nell’utilizzo di Grok in seguito ai submit pubblici del CEO Elon Musk che lo ritraggono in bikini, generati da Grok.

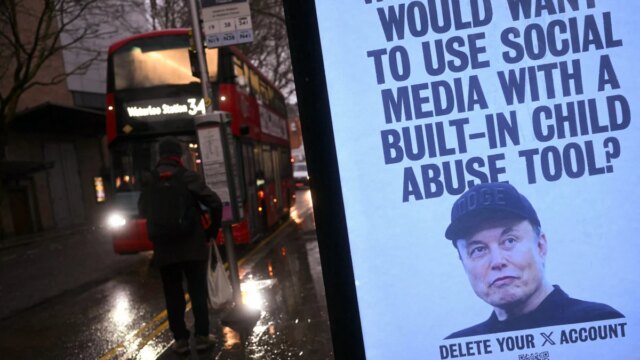

“Si tratta di un abuso su scala industriale di donne e ragazze”, ha detto alla pubblicazione l’amministratore delegato del CCDH Imran Ahmed. “Ci sono stati strumenti di nudizzazione, ma non hanno mai avuto la distribuzione, la facilità d’uso o l’integrazione in una grande piattaforma che Elon Musk ha fatto con Grok.”

Grok è stato criticato per aver generato materiale pedopornografico (CSAM), in seguito a segnalazioni secondo cui il chatbot X produceva immagini di minori in abiti succinti. La piattaforma ha riconosciuto il problema e ha affermato che stava risolvendo urgentemente le “lacune nelle garanzie”.

Velocità della luce mashable

La società madre di Grok, xAI, è oggetto di indagine da parte di diversi governi stranieri e dello stato della California per il suo ruolo nella generazione di contenuti sessualizzati o Deepfake “svestiti”. di persone e minori. Alcuni paesi hanno addirittura vietato temporaneamente la piattaforma mentre le indagini continuano.

Il 14 gennaio, xAI ha dichiarato che avrebbe impedito a Grok di modificare le foto di persone reali caricate dagli utenti per mostrare abiti succinti, i problemi originali segnalati dagli utenti all’inizio di questo mese. Tuttavia, recenti segnalazioni da parte del Custode ha scoperto che gli utenti dell’app Grok erano ancora in grado di produrre immagini modificate dall’intelligenza artificiale di donne vere modificate in bikini e quindi caricarle sul sito.

Questo Tweet non è al momento disponibile. Potrebbe essere in fase di caricamento o è stato rimosso.

In un reportage di agosto, l’editore di Mashable Timothy Beck Werth ha notato problemi con i guardrail di sicurezza segnalati da Grok, incluso il fatto che Grok Think about ha prontamente prodotto immagini e video sessualmente allusivi di persone reali. Grok Think about embrace impostazioni di moderazione e protezioni intese a bloccare determinati suggerimenti e risposte, ma Musk ha anche pubblicizzato Grok come uno dei pochi chatbot tradizionali che includeva un’impostazione “piccante” per i contenuti sessuali. OpenAI ha anche accennato a un’impostazione NSFW, in mezzo a trigger legali che sostengono che il suo prodotto ChatGPT non sia sicuro per gli utenti.

Gli enti di vigilanza sulla sicurezza on-line hanno da tempo messo in guardia il pubblico sul ruolo dell’intelligenza artificiale generativa nell’aumento del numero di materiale pedopornografico generato sinteticamente, nonché di immagini intime non consensuali (NCII), affrontate nel Take It Down Act del 2025. Secondo la nuova legge statunitense, gli editori on-line sono tenuti a rispettare le richieste di rimozione di deepfake non consensuali, pena sanzioni.

Un rapporto del 2024 del Fondazione Internet Watch (IWF) hanno scoperto che gli strumenti di intelligenza artificiale generativa erano direttamente collegati all’aumento del numero di materiale pedopornografico sul darkish internet, raffigurando prevalentemente giovani ragazze in scenari sessuali o alterando digitalmente la pornografia reale per includere le sembianze di bambini. Gli strumenti di intelligenza artificiale e le app di “nudificazione” sono stati collegati all’aumento cyberbullismo E Abuso sessuale consentito dall’intelligenza artificiale.

AGGIORNAMENTO: 22 gennaio 2026, 15:33 Questa storia è stata aggiornata per includere maggiori dettagli sulla sequenza temporale del rapporto e sulle date dei check.