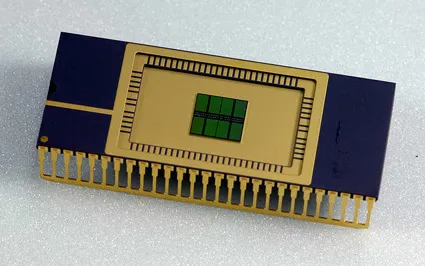

Quando parliamo del costo dell’infrastruttura AI, l’attenzione è solitamente rivolta a Nvidia e alle GPU, ma la memoria è una parte sempre più importante del quadro. Mentre gli hyperscaler si preparano a costruire nuovi information middle per miliardi di dollari, il prezzo dei chip DRAM è aumentato circa 7 volte nell’ultimo anno.

Allo stesso tempo, c’è una crescente disciplina nell’orchestrare tutta quella memoria per garantire che i dati giusti arrivino all’agente giusto al momento giusto. Le aziende che lo padroneggiano saranno in grado di effettuare le stesse question con meno token, il che può fare la differenza tra abbandonare e restare in attività.

Analista di semiconduttori Doug O’Laughlin dà uno sguardo interessante all’importanza dei chip di memoria nel suo Substack, dove parla con Val Bercovici, responsabile AI di Weka. Sono entrambi esperti di semiconduttori, quindi l’attenzione è più sui chip che sull’architettura più ampia; Anche le implicazioni per il software program AI sono piuttosto significative.

Mi ha particolarmente colpito questo passaggio, in cui Bercovici guarda alla crescente complessità dell’ La documentazione di memorizzazione nella cache dei prompt di Anthropic:

Il risultato è se andiamo alla pagina dei prezzi di caching rapido di Anthropic. È iniziato come una pagina molto semplice sei o sette mesi fa, soprattutto durante il lancio di Claude Code: basta “usare la memorizzazione nella cache, è più economico”. Ora è un’enciclopedia di consigli su quante scritture cache effettuare pre-acquisto. Hai livelli di 5 minuti, che sono molto comuni nel settore, o livelli di 1 ora – e niente di più. E’ una cosa davvero importante. Quindi ovviamente hai tutti i tipi di opportunità di arbitraggio sui prezzi per le letture della cache in base al numero di scritture della cache che hai preacquistato.

La domanda qui è per quanto tempo Claude conserva il tuo immediate nella memoria cache: puoi pagare per una finestra di 5 minuti o pagare di più per una finestra di un’ora. È molto più economico attingere ai dati ancora nella cache, quindi se li gestisci correttamente, puoi risparmiare moltissimo. C’è però un problema: ogni nuovo bit di dati aggiunto alla question potrebbe far uscire qualcos’altro dalla finestra della cache.

Si tratta di cose complesse, ma il risultato è abbastanza semplice: la gestione della memoria nei modelli di intelligenza artificiale costituirà una parte importante dell’intelligenza artificiale in futuro. Le aziende che lo fanno bene saliranno ai vertici.

E ci sono molti progressi da fare in questo nuovo campo. A ottobre ho parlato di una startup chiamata TensorMesh che stava lavorando su un livello dello stack noto come ottimizzazione della cache.

Evento Techcrunch

Boston, MA

|

23 giugno 2026

Esistono opportunità in altre parti dello stack. Advert esempio, più in basso c’è la questione di come i information middle utilizzano i diversi tipi di memoria di cui dispongono. (L’intervista embody una bella discussione su quando vengono utilizzati i chip DRAM invece di HBM, anche se è piuttosto approfondita nelle erbacce dell'{hardware}.) Più in alto nello stack, gli utenti finali stanno cercando di capire come strutturare i loro sciami di modelli per sfruttare la cache condivisa.

Man mano che le aziende miglioreranno nell’orchestrazione della memoria, utilizzeranno meno token e l’inferenza diventerà più economica. Nel frattempo, i modelli stanno diventando più efficienti nell’elaborazione di ciascun tokenabbassando ulteriormente i costi. Man mano che i costi dei server diminuiscono, molte applicazioni che ora non sembrano fattibili inizieranno a diventare redditizie.