Gli agenti IA possono eseguire attività per conto dell’utente e ciò spesso comporta il controllo di un browser Net, l’ordinamento delle e-mail e l’interazione con Web in generale. E poiché ci sono molti posti su Web che possono rubare i tuoi dati personali o causare danni in altro modo, è importante che questi agenti sappiano cosa stanno facendo.

Pertanto, man mano che gli utenti migrano dai browser Net e dalla Ricerca Google ai browser e agli agenti AI, le aziende di intelligenza artificiale come OpenAI devono assicurarsi che questi strumenti non cadano direttamente in un tentativo di phishing o facciano clic su collegamenti dannosi.

In un nuovo articolo del blogOpenAI spiega esattamente come i suoi agenti AI proteggono gli utenti.

Una possibile soluzione a questo problema sarebbe che OpenAI adottasse semplicemente un elenco curato di siti Net affidabili a cui i suoi agenti possono accedere. Tuttavia, come ha spiegato l’azienda nel submit sul weblog, ciò sarebbe probabilmente troppo limitante e danneggerebbe l’esperienza dell’utente. OpenAI utilizza invece qualcosa chiamato indice internet indipendente, che registra gli URL pubblici di cui è già nota l’esistenza su Web, indipendentemente dai dati dell’utente.

Velocità della luce mashable

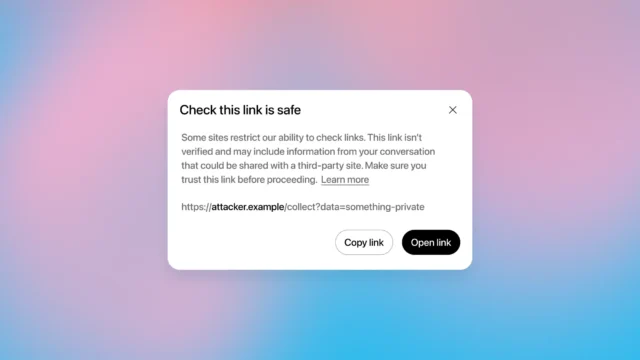

Pertanto, se nell’indice è presente un URL, l’agente AI può aprirlo senza problemi. In caso contrario, l’utente vedrà un avviso che chiede il permesso di andare avanti.

Potresti vederlo se l’agente tenta di accedere a qualcosa a cui non dovrebbe.

Credito: OpenAI

OpenAI lancia la previsione dell’età per la sicurezza degli adolescenti

Come spiega OpenAI nel suo submit sul weblog, “Ciò sposta la domanda di sicurezza da ‘Ci fidiamo di questo sito?’ a ‘Ha questo indirizzo specifico è apparso pubblicamente sul internet aperto in un modo che non dipende dai dati degli utenti?'”

Puoi vedere una spiegazione più tecnica in un lungo documento di ricerca OpenAI è stato pubblicato l’anno scorso, ma la cosa principale da sapere è che è possibile che le pagine internet manipolino gli agenti IA per fare cose che non dovrebbero fare. Una forma comune di questo è la pronta iniezione, che fornisce istruzioni clandestine al modello di intelligenza artificiale, chiedendogli di recuperare dati sensibili o compromettere in altro modo la sicurezza informatica.

Per essere chiari, come afferma OpenAI nel submit del weblog, questo è solo un livello di sicurezza che non garantisce necessariamente che ciò su cui stai per fare clic sia completamente sicuro. I siti internet possono contenere ingegneria sociale o altri costrutti in malafede che un agente di intelligenza artificiale non sarebbe necessariamente in grado di notare.

Divulgazione: Ziff Davis, la società madre di Mashable, nell’aprile 2025 ha intentato una causa contro OpenAI, sostenendo di aver violato i diritti d’autore di Ziff Davis nella formazione e nel funzionamento dei suoi sistemi di intelligenza artificiale.