Lively Listing, LDAP e i primi PAM furono creati per gli esseri umani. Gli agenti e le macchine IA erano l’eccezione. Oggi superano il numero delle persone in un rapporto di 82 a 1 e quel modello di identità incentrato sull’uomo sta crollando alla velocità delle macchine.

Gli agenti IA rappresentano la classe in più rapida crescita e meno governata tra queste identità di macchine e non si limitano advert autenticarsi, ma agiscono. ServiceNow ha speso circa 11,6 miliardi di dollari in acquisizioni di sicurezza solo nel 2025, un segnale che l’identità, e non i modelli, sta diventando il piano di controllo del rischio IA aziendale.

La ricerca 2025 di CyberArk conferma ciò che i crew di sicurezza e i costruttori di intelligenza artificiale sospettavano da tempo: le identità delle macchine ora superano di gran lunga quelle umane. Microsoft Gli utenti di Copilot Studio hanno creato oltre 1 milione di agenti IA in un solo trimestre, in aumento del 130% rispetto al periodo precedente. Gartner prevede che entro il 2028, il 25% delle violazioni aziendali risaliranno all’abuso degli agenti IA.

Perché le architetture legacy falliscono su scala macchina

I costruttori non creano agenti ombra o account di servizio con autorizzazioni eccessive per negligenza. Lo fanno perché l’IAM del cloud è lento, le revisioni della sicurezza non si adattano in modo chiaro ai flussi di lavoro degli agenti e la pressione della produzione premia la velocità rispetto alla precisione. Le credenziali statiche diventano il percorso di minor resistenza, fino a diventare il vettore della violazione.

Gli analisti di Gartner spiegano il problema principale in un rapporto pubblicato a maggio: “Gli approcci IAM tradizionali, progettati per gli utenti umani, non riescono a soddisfare i requisiti specifici delle macchine, come dispositivi e carichi di lavoro.”

La loro ricerca identifica il motivo per cui il retrofitting fallisce: “L’adeguamento degli approcci IAM umani per adattarsi ai casi d’uso IAM delle macchine porta a una gestione frammentata e inefficace delle identità delle macchine, entrando in conflitto con i mandati normativi ed esponendo l’organizzazione a rischi inutili.”

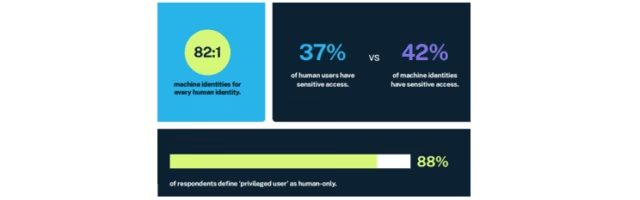

Il divario nella governance è netto. Il panorama della sicurezza dell’identità di CyberArk nel 2025 Un sondaggio condotto su 2.600 decisori nel campo della sicurezza rivela una pericolosa disconnessione: sebbene le identità delle macchine ora superino quelle umane in un rapporto di 82 a 1, l’88% delle organizzazioni definisce ancora solo le identità umane come “utenti privilegiati”. Il risultato è che le identità delle macchine hanno effettivamente tassi di accesso sensibile più elevati rispetto a quelli umani.

Quella cifra del 42% rappresenta milioni di chiavi API, account di servizio e processi automatizzati con accesso ai gioielli della corona, il tutto regolato da politiche progettate per i dipendenti che timbrano entrata e uscita.

Il divario di visibilità aggrava il problema. UN Sondaggio Gartner Un campione di 335 chief IAM ha scoperto che i crew IAM sono responsabili solo del 44% delle identità delle macchine di un’organizzazione, il che significa che la maggior parte opera al di fuori della visibilità della sicurezza. Senza una strategia IAM coesa, avverte Gartner, “le organizzazioni rischiano di compromettere la sicurezza e l’integrità della propria infrastruttura IT”.

IL Guida dei leader Gartner spiega perché gli account di servizio legacy creano un rischio sistemico: persistono dopo che i carichi di lavoro che supportano scompaiono, lasciando credenziali orfane senza proprietario o ciclo di vita chiari.

In various violazioni aziendali indagate nel 2024, gli aggressori non hanno compromesso modelli o endpoint. Hanno riutilizzato chiavi API di lunga durata legate a flussi di lavoro di automazione abbandonati: chiavi di cui nessuno si rendeva conto fossero ancora attive perché l’agente che le aveva create non esisteva più.

Elia ZaitsevCrowdStrike Il CTO, ha spiegato perché gli aggressori si sono spostati dagli endpoint verso l’identità in una recente intervista a VentureBeat: “Il cloud, gli strumenti di gestione remota e di identità e le credenziali legittime sono dove l’avversario si è mosso perché è troppo difficile operare senza vincoli sull’endpoint. Perché provare a bypassare e gestire una piattaforma sofisticata come CrowdStrike sull’endpoint quando potresti accedere come utente amministratore?”

Perché l’intelligenza artificiale agentica infrange i presupposti sull’identità

L’emergere di agenti IA che richiedono le proprie credenziali introduce una categoria di identità della macchina che i sistemi legacy non avevano mai previsto o per la quale non erano stati progettati. I ricercatori di Gartner chiamano specificamente l’intelligenza artificiale degli agenti come un caso d’uso critico: “gli agenti di intelligenza artificiale richiedono credenziali per interagire con altri sistemi. In alcuni casi, utilizzano credenziali umane delegate, mentre in altri operano con le proprie credenziali. Queste credenziali devono essere meticolosamente particular per aderire al principio del privilegio minimo.”

I ricercatori citano anche il Mannequin Context Protocol (MCP) come esempio di questa sfida, lo stesso protocollo che i ricercatori sulla sicurezza hanno segnalato per la sua mancanza di autenticazione integrata. MCP non si limita a mancare l’autenticazione: fa crollare i tradizionali confini dell’identità consentendo agli agenti di attraversare dati e strumenti senza una superficie di identità stabile e verificabile.

Il problema della governance si aggrava quando le organizzazioni distribuiscono più strumenti GenAI contemporaneamente. I crew di sicurezza hanno bisogno di visibilità su quali integrazioni di intelligenza artificiale abbiano capacità di azione, inclusa la capacità di eseguire attività, non solo di generare testo, e se tali capacità siano state particular in modo appropriato.

Le piattaforme che uniscono identità, endpoint e telemetria sul cloud stanno emergendo come l’unico modo praticabile per rilevare l’abuso degli agenti in tempo reale. Gli utensili a punta frammentata semplicemente non riescono a tenere il passo con il movimento laterale della velocità della macchina.

Le interazioni macchina-macchina operano già su una scala e con una velocità che i modelli di governance umana non sono mai stati progettati per gestire.

Anticipare i cambiamenti dinamici dell’identità dei servizi

La ricerca di Gartner indica le identità di servizio dinamiche come il percorso da seguire. Sono particular credenziali effimere, con ambito limitato e guidate da coverage che riducono drasticamente la superficie di attacco. Per questo motivo, Gartner consiglia ai chief della sicurezza di “passare a un modello di identità di servizio dinamico, anziché passare per impostazione predefinita a un modello di account di servizio legacy. Le identità di servizio dinamiche non richiedono la creazione di account separati, riducendo così il sovraccarico di gestione e la superficie di attacco”.

L’obiettivo finale è ottenere un accesso just-in-time e zero privilegi permanenti. Le piattaforme che uniscono identità, endpoint e telemetria sul cloud rappresentano sempre più l’unico modo praticabile per rilevare e contenere gli abusi degli agenti lungo l’intera catena di attacchi alle identità.

Passi pratici che gli sviluppatori di sicurezza e intelligenza artificiale possono intraprendere oggi

Le organizzazioni che riescono a ottenere correttamente l’identità dell’agente lo trattano come un problema di collaborazione tra i crew di sicurezza e i costruttori di intelligenza artificiale. Sulla base della Leaders’ Information di Gartner, delle indicazioni della OpenID Basis e delle greatest follow dei fornitori, queste priorità stanno emergendo per le aziende che implementano agenti AI.

-

Esegui innanzitutto un’individuazione e un controllo completi di ogni account e credenziale. È una buona thought definire prima una base di riferimento per vedere quanti account e credenziali sono in uso su tutte le macchine dell’IT. I CISO e i chief della sicurezza dicono a VentureBeat che spesso vengono fuori da sei a dieci volte più identità di quelle che il crew di sicurezza conosceva prima dell’audit. Una catena alberghiera ha scoperto di aver tracciato solo un decimo delle identità delle sue macchine prima dell’audit.

-

Crea e gestisci attentamente l’inventario degli agenti prima della produzione. Essere al prime di tutto ciò garantisce che gli sviluppatori di intelligenza artificiale sappiano cosa stanno implementando e che i crew di sicurezza sappiano cosa devono monitorare. Quando c’è troppo divario tra queste funzioni, è più facile che vengano creati agenti ombra, eludendo la governance nel processo. Un registro condiviso dovrebbe tenere traccia della proprietà, delle autorizzazioni, dell’accesso ai dati e delle connessioni API per ogni identità dell’agente prima che gli agenti raggiungano gli ambienti di produzione.

-

Punta tutto sulle identità di servizio dinamiche ed eccelli. Transizione da account di servizio statici advert different native del cloud come ruoli AWS IAM, identità gestite di Azure o account di servizio Kubernetes. Queste identità sono effimere e necessitano di essere ben particular, gestite e guidate da politiche. L’obiettivo è eccellere nella conformità fornendo allo stesso tempo agli sviluppatori di intelligenza artificiale le identità di cui hanno bisogno per creare app.

-

Implementa credenziali just-in-time su segreti statici. L’integrazione del provisioning delle credenziali just-in-time, della rotazione automatica dei segreti e delle impostazioni predefinite dei privilegi minimi nelle pipeline CI/CD e nei framework degli agenti è fondamentale. Questi sono tutti elementi fondamentali del principio zero belief che devono essere fondamentali per le pipeline devops. Segui il consiglio dei chief esperti della sicurezza che difendono gli sviluppatori di intelligenza artificiale, che spesso dicono a VentureBeat di trasmettere il consiglio di non fidarsi mai della sicurezza perimetrale con flussi di lavoro di sviluppo AI o processi CI/CD. Punta sul Zero Belief e sulla sicurezza dell’identità quando si tratta di proteggere i flussi di lavoro degli sviluppatori di intelligenza artificiale.

-

Stabilire catene di delega verificabili. Quando gli agenti generano agenti secondari o invocano API esterne, le catene di autorizzazione diventano difficili da tracciare. Assicurati che gli esseri umani siano responsabili di tutti i servizi, inclusi gli agenti IA. Le imprese hanno bisogno di linee guida comportamentali e di rilevamento delle derive in tempo reale per mantenere la responsabilità.

-

Distribuire il monitoraggio continuo. In linea con i precetti di zero belief, monitora continuamente ogni utilizzo delle credenziali della macchina con l’obiettivo deliberato di eccellere in termini di osservabilità. Ciò embody il controllo in quanto aiuta a rilevare attività anomale come l’escalation di privilegi non autorizzati e lo spostamento laterale.

-

Valutare la gestione della postura. Valutare i potenziali percorsi di sfruttamento, l’entità del possibile danno (raggio dell’esplosione) e qualsiasi accesso amministrativo ombra. Ciò comporta la rimozione degli accessi non necessari o obsoleti e l’identificazione delle configurazioni errate che gli aggressori potrebbero sfruttare.

-

Inizia advert applicare la gestione del ciclo di vita degli agenti. Ogni agente necessita della supervisione umana, sia come parte di un gruppo di agenti che nel contesto di un flusso di lavoro basato su agenti. Quando gli sviluppatori di intelligenza artificiale passano a nuovi progetti, i loro agenti dovrebbero attivare gli stessi flussi di lavoro di offboarding dei dipendenti in partenza. Gli agenti orfani con privilegi permanenti possono diventare vettori di violazioni.

-

Dai priorità alle piattaforme unificate rispetto alle soluzioni puntuali. Gli strumenti frammentati creano una visibilità frammentata. Le piattaforme che unificano identità, endpoint e sicurezza nel cloud offrono agli sviluppatori di intelligenza artificiale visibilità self-service, offrendo al tempo stesso ai crew di sicurezza il rilevamento interdominio.

Aspettatevi di vedere il divario ampliarsi nel 2026

Il divario tra ciò che i costruttori di intelligenza artificiale implementano e ciò che i crew di sicurezza possono governare continua advert ampliarsi. Sfortunatamente, ogni importante transizione tecnologica ha portato anche a un’altra generazione di violazioni della sicurezza, spesso imponendo una resa dei conti unica a livello di settore. Proprio come le configurazioni errate del cloud ibrido, l’intelligenza artificiale ombra e la diffusione delle API continuano a mettere a dura prova i chief della sicurezza e gli sviluppatori di intelligenza artificiale che supportano, il 2026 vedrà ampliarsi il divario tra ciò che può essere contenuto quando si tratta di attacchi all’identità delle macchine e ciò che deve essere migliorato per fermare avversari determinati.

Il rapporto 82 a 1 non è statico. Sta accelerando. Le organizzazioni che continuano a fare affidamento su architetture IAM human-first non si limitano advert accettare debiti tecnici; stanno costruendo modelli di sicurezza che si indeboliscono con ogni nuovo agente distribuito.

L’intelligenza artificiale agentica non viola la sicurezza perché è intelligente: viola la sicurezza perché moltiplica l’identità più velocemente di quanto la governance possa seguire. Per trasformare quella che per molte organizzazioni è una delle debolezze più evidenti in termini di sicurezza in un punto di forza, bisogna rendersi conto che la sicurezza delle identità legacy e basata sul perimetro non può competere con l’intensità, la velocità e la portata degli attacchi macchina su macchina che rappresentano la nuova normalità e che prolifereranno nel 2026.