Modelli linguistici ricorsivi (RLM) sono una tecnica di inferenza sviluppata dai ricercatori del MIT CSAIL che trattano i immediate lunghi come un ambiente esterno al modello. Invece di forzare l’intero immediate nella finestra di contesto del modello, il framework consente a LLM di esaminare, scomporre e richiamare in modo ricorsivo se stesso a livello di codice su frammenti di testo.

Invece di espandere le finestre di contesto o riassumere vecchie informazioni, il workforce del MIT riformula il ragionamento sul contesto lungo come un problema di sistema. Consentendo ai modelli di trattare i immediate come qualcosa che possono ispezionare con il codice, i modelli linguistici ricorsivi consentono agli LLM di ragionare su milioni di token senza riqualificazione. Ciò offre alle aziende un percorso pratico verso attività a lungo orizzonte come l’analisi della base di codice, la revisione legale e il ragionamento in più fasi che regolarmente rompono i modelli odierni.

Poiché il framework è progettato come wrapper attorno ai modelli esistenti, può fungere da sostituto immediato per le applicazioni che effettuano chiamate dirette agli LLM.

Il problema del contesto LLM

Anche se i modelli di frontiera stanno diventando sempre più sofisticati nel ragionamento, la loro capacità di elaborare enormi quantità di informazioni non cresce allo stesso ritmo. Questo collo di bottiglia è causato da due limitazioni distinte: il rigido vincolo fisico sulla quantità di testo che un modello può elaborare contemporaneamente (lunghezza del contesto) e il “marciume del contesto”.

La sfida, sostengono i ricercatori, è se sia possibile ridimensionare la dimensione effettiva del contesto dei LLM di uso generale per ordini di grandezza senza riqualificarli. Questa capacità sta diventando sempre più importante per le applicazioni aziendali, dove gli LLM vengono adottati per attività a lungo orizzonte che richiedono l’elaborazione di milioni di token: una sfida che, secondo Zhang, non può essere risolta semplicemente espandendo le finestre di contesto.

“Esiste un argomento di entropia che implica che sono necessari esponenzialmente più campioni di dati man mano che si aumenta la dimensione effettiva della finestra del contesto”, ha detto a VentureBeat Alex Zhang, coautore dell’articolo.

Gli approcci attuali per estendere il contesto spesso si basano sulla compattazione, in cui il modello riassume le parti più vecchie della conversazione per liberare spazio. Tuttavia, questo metodo fallisce per le attività che richiedono l’accesso casuale a dettagli specifici situati nelle parti precedenti del immediate.

Come funzionano gli RLM

Il concetto alla base degli RLM è tratto da algoritmi “out-of-core” utilizzati nell’informatica classica. Questi algoritmi sono progettati per elaborare set di dati troppo grandi per essere contenuti nella memoria principale di un pc, mantenendo i dati su un disco rigido e recuperando solo i blocchi necessari secondo necessità.

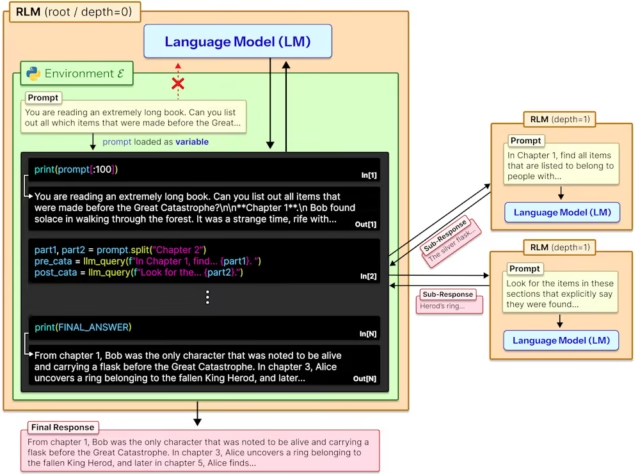

Gli RLM applicano questa logica all’intelligenza artificiale generativa. Invece di inviare un lungo immediate direttamente alla rete neurale, il framework carica il testo come variabile stringa all’interno di un ambiente di codifica Python. Al LLM viene fornito un contesto generale sui dati (come il conteggio totale dei caratteri) ma inizialmente non “vede” il testo.

Una volta memorizzato il immediate come variabile, LLM funge da programmatore. Scrive codice Python per interagire con la variabile esterna, utilizzando comandi customary per sbirciare nei dati. Advert esempio, il modello potrebbe utilizzare espressioni regolari per cercare parole chiave specifiche come “Capitolo 1” o “risultati finanziari”.

Quando l’esecuzione del codice trova uno snippet rilevante, l’RLM inserisce solo quel pezzo specifico nella sua finestra di contesto attiva per l’analisi.

Advert esempio, se il immediate è un libro voluminoso, LLM potrebbe scrivere un ciclo che identifica i confini del capitolo e quindi attivare una sottochiamata per riassumere ciascun capitolo individualmente.

L’architettura coinvolge tipicamente due agenti. Un “modello del linguaggio root”, spesso un modello advert alta capacità come GPT-5, funge da orchestratore. Pianifica l’approccio, scrive il codice e gestisce il flusso di dati all’interno dell’ambiente REPL. Un “modello linguistico ricorsivo”, spesso un modello più veloce ed economico, funge da lavoratore. Il LM root chiama questo lavoratore per elaborare i frammenti di testo specifici isolati dal codice.

Poiché il immediate risiede nella memoria dell’ambiente anziché nella finestra di contesto del modello, il sistema può gestire enter molto più grandi del limite di coaching del modello. È importante sottolineare che per l’utente finale l’RLM si comporta esattamente come un modello customary: accetta una stringa e restituisce una risposta. Ciò consente ai workforce aziendali di scambiare le chiamate API customary con RLM.

Per gli sviluppatori che desiderano sperimentare, il codice RLM è attualmente disponibile su GitHub.

“Un argomento chiave a favore degli RLM è che i compiti più complessi possono essere scomposti in sotto-compiti più piccoli, ‘locali’,” ha detto Zhang. “Tuttavia, come eseguire questa scomposizione contesto/problema non è banale e il modello deve essere in grado di farlo.”

RLM in azione

Per convalidare il quadro, i ricercatori hanno testato gli RLM rispetto a modelli di base e altri approcci advert agenti come CodeAct e agenti di riepilogo in una varietà di attività a lungo contesto, tra cui il recupero e la risposta a domande multi-hop.

I risultati hanno dimostrato forti guadagni di efficiency su una scala di oltre 10 milioni di token. SU SfogliaComp-Plusun benchmark che prevedeva enter da 6 a 11 milioni di token, i modelli base customary hanno fallito completamente, ottenendo un punteggio dello 0%. Al contrario, l’RLM alimentato da GPT-5 ha ottenuto un punteggio pari al 91,33%, sovraperformando significativamente l’Agente di Sommario (70,47%) e CodiceAct (51%).

Il framework eccelleva anche in compiti con elevata complessità computazionale. Su OOLONG-Pairs, un benchmark di ragionamento ricco di informazioni in cui la difficoltà scala quadraticamente con la lunghezza dell’enter, i modelli base GPT-5 hanno fallito catastroficamente con un punteggio di appena lo 0,04%. L’RLM ha ottenuto un punteggio F1 (una misura equilibrata di precisione e richiamo) del 58%, dimostrando capacità emergenti di gestire compiti densi che paralizzano i modelli customary. Allo stesso modo, per quanto riguarda le attività di comprensione del codice (benchmark CodeQA), l’RLM ha più che raddoppiato le prestazioni del modello base GPT-5, passando dal 24% al 62%.

Per quanto riguarda il problema del deterioramento del contesto, i dati hanno mostrato che mentre le prestazioni GPT-5 di base peggiorano rapidamente con l’aumentare della complessità delle attività, le prestazioni RLM rimangono stabili, superando costantemente il modello base su contesti più lunghi di 16.000 token.

Nonostante la maggiore complessità del flusso di lavoro, gli RLM spesso mantenevano costi medi paragonabili o inferiori rispetto a quelli di base. Sul benchmark SfogliaComp-Plus, l’RLM period fino a tre volte più economico rispetto al riepilogo di base.

Tuttavia, i ricercatori hanno notato che mentre i costi medi sono bassi, le traiettorie RLM sono “a coda lunga”. Le esecuzioni anomale possono diventare costose se il modello rimane bloccato in cicli o esegue verifiche ridondanti. Sebbene GPT-5 fosse conservatore nelle sue sottochiamate, il file open supply Qwen3-codificatore il modello a volte tentava migliaia di sottochiamate per compiti semplici.

“Oggi, probabilmente dovrai implementare i tuoi guardrail e la tua logica per controllare il comportamento dell’RLM”, ha detto Zhang. Tuttavia, egli ipotizza che i modelli futuri potrebbero essere addestrati per gestire i propri finances di calcolo in modo più efficace. Aziende come Prime Mind stanno pianificando di farlo integrare RLM nel processo di addestramento dei modelli, possibilmente affrontando i casi limite in cui il finances di inferenza del modello aumenta.

Per gli architetti aziendali che devono decidere dove piazzare le proprie scommesse, il framework RLM offre un nuovo strumento per gestire problemi advert alta densità di informazioni.

“Penso che gli RLM siano ancora estremamente utili per i chatbot (si pensi alle lunghe cronologie delle chat), ma alla positive sostengono un modo alternativo di utilizzare gli LM”, ha detto Zhang. “Penso che gli RLM funzionino in tandem con metodi di recupero customary come RAG; non servono come sostituti e possono essere utilizzati in contesti diversi o insieme.”