I ricercatori di Google e del MIT hanno condotto a analisi esaustiva dei sistemi advert agenti e la dinamica tra il numero di agenti, la struttura di coordinamento, la capacità del modello e le proprietà del compito. Sebbene il sentimento prevalente nel settore sia stato “più agenti sono tutto ciò di cui hai bisogno”, la ricerca suggerisce che il ridimensionamento dei group di agenti non è un percorso garantito per migliorare le prestazioni.

Sulla base dei loro risultati, i ricercatori hanno definito un modello quantitativo in grado di prevedere le prestazioni di un sistema advert agenti su un compito invisibile. Il loro lavoro rivela che l’aggiunta di più agenti e strumenti agisce come un’arma a doppio taglio: sebbene possa sbloccare le prestazioni su problemi specifici, spesso introduce spese generali inutili e rendimenti decrescenti su altri.

Questi risultati offrono una roadmap critica per gli sviluppatori e i decisori aziendali che cercano di determinare quando implementare architetture multi-agente complesse rispetto a soluzioni advert agente singolo più semplici ed economiche.

Lo stato dei sistemi advert agenti

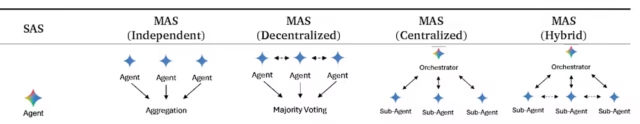

Per comprendere le implicazioni dello studio, è necessario distinguere tra le due architetture principali oggi in uso. I sistemi advert agente singolo (SAS) sono caratterizzati da un luogo di ragionamento solitario. In questa configurazione, tutta la percezione, la pianificazione e l’azione avvengono all’interno di un singolo ciclo sequenziale controllato da un’istanza LLM, anche quando il sistema utilizza strumenti, auto-riflessione o ragionamento basato sulla catena di pensiero (CoT). Al contrario, un sistema multi-agente (MAS) comprende più agenti supportati da LLM che comunicano tramite passaggio di messaggi strutturati, memoria condivisa o protocolli orchestrati.

Il settore delle imprese ha visto a aumento di interesse per il MASguidato dalla premessa che la collaborazione specializzata può costantemente superare i sistemi advert agente singolo. Man mano che le attività diventano più complesse e richiedono un’interazione prolungata con gli ambienti (advert esempio, assistenti di codifica o robotic di analisi finanziaria), gli sviluppatori spesso presumono che dividere il lavoro tra agenti “specializzati” sia l’approccio migliore.

Tuttavia, i ricercatori sostengono che, nonostante questa rapida adozione, non rimane alcun quadro quantitativo di principio per prevedere quando l’aggiunta di agenti amplifica le prestazioni e quando le erode.

Un contributo chiave del documento è la distinzione tra compiti “statici” e “agenti”. I ricercatori hanno applicato una “lista di controllo dei benchmark agenti” per differenziare i compiti che richiedono interazioni prolungate in più fasi, raccolta iterativa di informazioni e perfezionamento della strategia adattiva da quelli che non lo richiedono. Questa distinzione è vitale perché le strategie che funzionano per la risoluzione statica dei problemi (come votare in un quiz di codifica) spesso falliscono se applicate a compiti reali in cui il “overhead di coordinamento” e la “propagazione degli errori” possono diffondersi attraverso il processo di risoluzione dei problemi.

Testare i limiti della collaborazione

Per isolare gli effetti specifici dell’architettura del sistema, i ricercatori hanno progettato un rigoroso quadro sperimentale. Hanno testato 180 configurazioni uniche che coinvolgono cinque architetture distinte, tre famiglie LLM (OpenAI, Google e Anthropic) e quattro benchmark di agenti. Le architetture includevano un gruppo di controllo advert agente singolo e quattro varianti multi-agente: indipendente (agenti paralleli senza comunicazione), centralizzato (agenti che riportano a un orchestratore), decentralizzato (dibattito peer-to-peer) e ibrido (un combine di gerarchia e comunicazione tra pari).

Lo studio è stato progettato per eliminare i “confondimenti di implementazione” standardizzando strumenti, strutture tempestive e funds simbolici. Ciò garantiva che, se un sistema multi-agente avesse sovraperformato un singolo agente, il guadagno potesse essere attribuito alla struttura di coordinamento piuttosto che all’accesso a strumenti migliori o a più risorse di calcolo.

I risultati mettono in discussione la narrativa “più è meglio”. La valutazione rivela che l’efficacia dei sistemi multi-agente è governata da “compromessi quantificabili tra proprietà architettoniche e caratteristiche del compito”. I ricercatori hanno identificato tre modelli dominanti che guidano questi risultati:

Compromesso tra coordinamento degli strumenti: Con funds computazionali fissi, i sistemi multi-agente soffrono di frammentazione del contesto. Quando un funds di elaborazione viene suddiviso tra più agenti, a ciascun agente viene lasciata una capacità insufficiente per l’orchestrazione degli strumenti rispetto a un singolo agente che mantiene un flusso di memoria unificato.

Di conseguenza, in ambienti con un numero elevato di strumenti, con più di 10 strumenti, l’efficienza dei sistemi multi-agente diminuisce drasticamente. Il ricercatore ha scoperto che le attività che richiedono molti strumenti subiscono una riduzione dell’efficienza di 2–6 volte quando si utilizzano sistemi multi-agente rispetto a quelli con agenti singoli. Le architetture più semplici diventano paradossalmente più efficaci perché evitano il sovraccarico di coordinamento che si aggrava con la complessità ambientale.

Saturazione della capacità: I dati hanno stabilito una soglia empirica di precisione pari a circa il 45% per le prestazioni del singolo agente. Una volta che la linea di base di un singolo agente supera questo livello, l’aggiunta di più agenti in genere produce rendimenti decrescenti o negativi.

Tuttavia, il coautore Xin Liu, ricercatore di Google e coautore dell’articolo, ha notato una sfumatura cruciale per gli adottanti aziendali. “Le imprese dovrebbero investire in entrambi [single- and multi-agent systems]”, ha detto a VentureBeat. “Modelli di base migliori aumentano la linea di base, ma per attività con scomponibilità naturale e potenziale di parallelizzazione (come il nostro benchmark Finance Agent con un miglioramento del +80,9%), il coordinamento multi-agente continua a fornire un valore sostanziale indipendentemente dalla capacità del modello.”

Errore dipendente dalla topologia: La struttura del group di agenti determina se gli errori vengono corretti o moltiplicati. Nei sistemi “indipendenti” in cui gli agenti lavorano in parallelo senza comunicare, gli errori sono stati amplificati di 17,2 volte rispetto al valore di riferimento del singolo agente. Al contrario, le architetture centralizzate contenevano questa amplificazione a 4,4 volte.

“L’elemento chiave di differenziazione è avere un collo di bottiglia di convalida dedicato che intercetta gli errori prima che si propaghino all’output finale”, ha affermato l’autore principale Yubin Kim, uno studente di dottorato al MIT. “Per contraddizioni logiche, ‘centralizzato’ riduce il tasso di riferimento… [by] 36,4%… Per gli errori di omissione del contesto, il termine “centralizzato” riduce… [by] 66,8%.”

Informazioni utili per l’implementazione aziendale

Per sviluppatori e chief aziendali, questi risultati offrono linee guida specifiche per costruire sistemi di intelligenza artificiale più efficienti.

-

La regola della “sequenzialità”: Prima di creare un group di agenti, analizza la struttura delle dipendenze della tua attività. Il più forte predittore del fallimento multi-agente sono le attività strettamente sequenziali. Se la Fase B si basa interamente sulla perfetta esecuzione della Fase A, un sistema advert agente singolo è probabilmente la scelta migliore. In questi scenari, gli errori si accumulano invece di annullarsi. Al contrario, se l’attività è parallela o scomponibile (advert esempio, analizzare tre diversi report finanziari contemporaneamente) i sistemi multi-agente offrono enormi vantaggi.

-

Non aggiustare ciò che non è rotto: Le imprese dovrebbero sempre confrontare prima con un singolo agente. Se un sistema advert agente singolo raggiunge una percentuale di successo superiore al 45% su un’attività specifica che non può essere facilmente scomposta, l’aggiunta di più agenti probabilmente peggiorerà le prestazioni e aumenterà i costi senza fornire valore.

-

Conta le tue API: Sii estremamente cauto quando applichi sistemi multi-agente advert attività che richiedono molti strumenti distinti. La suddivisione del funds dei token tra più agenti ne frammenta la memoria e il contesto. “Per integrazioni pesanti con più di circa 10 strumenti, i sistemi advert agente singolo sono probabilmente preferibili”, ha affermato Kim, sottolineando che lo studio ha osservato una “penalità di efficienza da 2 a 6 volte” per le varianti multi-agente in questi scenari.

-

Abbina la topologia all’obiettivo: Se è necessario un sistema multi-agente, la topologia deve corrispondere all’obiettivo specifico. Per le attività che richiedono elevata accuratezza e precisione, advert esempio finanza o codifica, il coordinamento centralizzato è superiore perché l’orchestratore fornisce un livello di verifica necessario. Per le attività che richiedono esplorazione, come la navigazione net dinamica, il coordinamento decentralizzato eccelle consentendo agli agenti di esplorare diversi percorsi simultaneamente.

-

La “Regola del 4”: Anche se potrebbe essere allettante costruire sciami enormi, lo studio ha scoperto che le dimensioni effettive dei group sono attualmente limitate a circa tre o quattro agenti. “Il limite di tre o quattro agenti che identifichiamo deriva da vincoli di risorse misurabili”, ha affermato Kim. Oltre a ciò, il sovraccarico della comunicazione cresce in modo super-lineare (nello specifico, con un esponente di 1.724), il che significa che il costo del coordinamento supera rapidamente il valore del ragionamento aggiunto.

Guardando al futuro: superare il limite di larghezza di banda

Sebbene le architetture attuali raggiungano un limite in caso di group di piccole dimensioni, questo è probabilmente un vincolo dei protocolli attuali piuttosto che un limite fondamentale dell’intelligenza artificiale. Il limite effettivo dei sistemi multi-agente deriva dal fatto che gli agenti attualmente comunicano in modo denso e advert alta intensità di risorse.

“Crediamo che questo sia un vincolo attuale, non un limite permanente”, ha affermato Kim, indicando alcune innovazioni chiave che possono sbloccare il potenziale della collaborazione tra agenti su larga scala:

Protocolli di comunicazione sparsi: “I nostri dati mostrano che la densità dei messaggi si satura a circa 0,39 messaggi per turno, oltre la quale i messaggi aggiuntivi aggiungono ridondanza anziché nuove informazioni. Un routing più intelligente potrebbe ridurre i costi generali”, ha affermato.

Scomposizione gerarchica: Invece di semplici sciami di 100 agenti, strutture di coordinamento annidate potrebbero suddividere il grafico della comunicazione.

Coordinamento asincrono: “I nostri esperimenti hanno utilizzato protocolli sincroni e i progetti asincroni potrebbero ridurre il sovraccarico di blocco”, ha affermato.

Routing sensibile alle capacità: “I nostri esperimenti sull’eterogeneità suggeriscono che mescolare strategicamente le capacità del modello può migliorare l’efficienza”, ha affermato Kim

Questo è qualcosa a cui guardare con ansia nel 2026. Fino advert allora, per l’architetto aziendale, i dati sono chiari: vincono i group più piccoli, più intelligenti e più strutturati.