Nell’ultimo anno, i decisori aziendali hanno dovuto affrontare un rigido compromesso architetturale nell’intelligenza artificiale vocale: adottare un modello di sintesi vocale (S2S) “nativo” per velocità e fedeltà emotiva, oppure attenersi a uno stack “modulare” per controllo e verificabilità. Quella scelta binaria si è evoluta in una distinta segmentazione del mercato, guidata da due forze simultanee che rimodellano il panorama.

Quella che una volta period una decisione sulle prestazioni è diventata una decisione di governance e conformità, poiché gli agenti vocali passano da progetti pilota a flussi di lavoro regolamentati e rivolti al cliente.

Da un lato, Google ha mercificato il livello di “intelligenza grezza”. Con il rilascio di Gemelli 2.5Flash e ora Gemelli 3.0 FlashGoogle si è posizionata come fornitore di servizi pubblici advert alto quantity con prezzi che rendono l’automazione vocale economicamente fattibile per flussi di lavoro precedentemente troppo economici per essere giustificati. OpenAI ha risposto advert agosto con un taglio del prezzo del 20% sulla sua API Realtime, riducendo all’incirca il divario con Gemini 2x – ancora significativo, ma non più insormontabile.

D’altro canto sta emergendo una nuova architettura modulare “Unificata”. Co-localizzando fisicamente i componenti disparati di una trascrizione dello stack vocale, fornitori di ragionamento e sintesi come Insieme AI stanno affrontando i problemi di latenza che in precedenza ostacolavano i progetti modulari. Questo contrattacco architetturale offre una velocità di tipo nativo pur mantenendo gli audit path e i punti di intervento richiesti dai settori regolamentati.

Insieme, queste forze stanno facendo crollare lo storico compromesso tra velocità e controllo nei sistemi vocali aziendali.

Per i dirigenti aziendali, la questione non riguarda più solo le prestazioni del modello. Si tratta di una scelta strategica tra un modello di utilità generalizzato ed economicamente vantaggioso e uno stack specifico per dominio e integrato verticalmente che supporta i requisiti di conformità, incluso se gli agenti vocali possono essere implementati su larga scala senza introdurre lacune di audit, rischi normativi o responsabilità a valle.

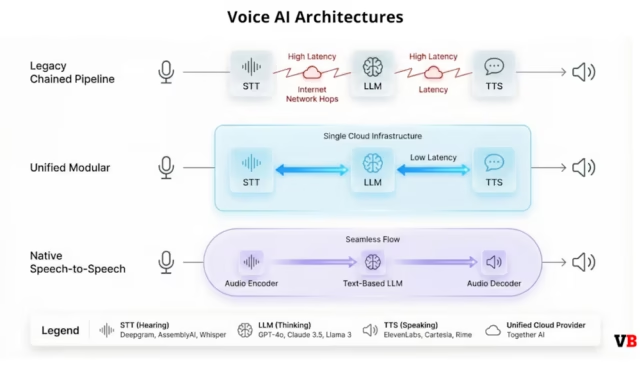

Comprendere i tre percorsi architettonici

Queste differenze architettoniche non sono accademiche; modellano direttamente la latenza, la verificabilità e la capacità di intervenire nelle interazioni vocali dal vivo.

Il mercato dell’intelligenza artificiale vocale aziendale si è consolidato attorno a tre architetture distinte, ciascuna ottimizzata per diversi compromessi tra velocità, controllo e costi. Modelli S2S – inclusi Gemini di Google in diretta E API in tempo reale di OpenAI — elabora gli enter audio in modo nativo per preservare i segnali paralinguistici come tono ed esitazione. Ma contrariamente alla credenza popolare, questi non sono veri modelli di discorso end-to-end. Funzionano come ciò che l’industria chiama “mezze cascate”: la comprensione dell’audio avviene in modo nativo, ma il modello esegue comunque un ragionamento basato su testo prima di sintetizzare l’output vocale. Questo approccio ibrido raggiunge una latenza compresa tra 200 e 300 msimitando da vicino i tempi di risposta umani in cui le pause superiori a 200 ms diventano percepibili e sembrano innaturali. Il compromesso è che questi passaggi intermedi del ragionamento rimangono opachi per le imprese, limitando la verificabilità e l’applicazione delle politiche.

Condotte tradizionali concatenate rappresentano l’estremo opposto. Questi stack modulari seguono un relè in tre fasi: motori di sintesi vocale come Nova-3 di Deepgram O Streaming universale di AssemblyAI trascrivere l’audio in testo, un LLM genera una risposta e fornitori di sintesi vocale come ElevenLabs o Sonic di Cartesia sintetizzare l’output. Ogni trasferimento introduce tempo di trasmissione in rete più sovraccarico di elaborazione. Mentre i singoli componenti hanno ottimizzato i tempi di elaborazione al di sotto dei 300 ms, il la latenza aggregata di andata e ritorno supera spesso i 500 msinnescando collisioni di “intervento” in cui gli utenti interrompono perché presumono che l’agente non li abbia sentiti.

Infrastruttura unificata rappresenta il contrattacco architetturale da parte dei fornitori modulari. Insieme l’intelligenza artificiale si co-localizza fisicamente Modelli STT (Whisper Turbo), LLM (Llama/Mixtral) e TTS (Rime, Cartesia) sugli stessi cluster GPU. I dati si spostano tra i componenti tramite interconnessioni di memoria advert alta velocità anziché tramite Web pubblico, riducendo la latenza totale a meno di 500 ms mantenendo la separazione modulare richiesta dalle aziende per la conformità. Insieme l’intelligenza artificiale misura la latenza TTS a circa 225 ms utilizzando Mist v2, lasciando un margine sufficiente per la trascrizione e il ragionamento entro il funds di 500 ms che definisce una conversazione naturale. Questa architettura offre la velocità di un modello nativo con la superficie di controllo di uno stack modulare, che può essere la soluzione “Goldilocks” che soddisfa contemporaneamente sia i requisiti di prestazioni che quelli di governance.

Il compromesso è una maggiore complessità operativa rispetto ai sistemi nativi completamente gestiti, ma per le imprese regolamentate story complessità spesso si collega direttamente al controllo richiesto.

Perché la latenza determina la tolleranza dell’utente e i parametri che lo dimostrano

La differenza tra un’interazione vocale riuscita e una chiamata abbandonata spesso si riduce a pochi millisecondi. Un solo secondo in più di ritardo può ridurre la soddisfazione degli utenti del 16%.

Tre parametri tecnici definiscono la preparazione alla produzione:

Tempo al primo token (TTFT) misura il ritardo dalla positive del discorso dell’utente all’inizio della risposta dell’agente. La conversazione umana tollera intervalli di circa 200 ms; qualsiasi cosa sembra più robotica. I modelli S2S nativi raggiungono da 200 a 300 ms, mentre gli stack modulari devono ottimizzare in modo aggressivo per rimanere sotto i 500 ms.

Tasso di errore delle parole (WER) misura l’accuratezza della trascrizione. Nova-3 di Deepgram offre un WER inferiore del 53,4% per lo streaming, mentre lo streaming universale di AssemblyAI dichiara una latenza di emissione delle parole più veloce del 41%.. Un singolo errore di trascrizione – “fatturazione” interpretato erroneamente come “costruzione” – corrompe l’intera catena di ragionamento a valle.

Fattore in tempo reale (RTF) misura se il sistema elabora il parlato più velocemente di quanto parlano gli utenti. Un RTF inferiore a 1.0 è obbligatorio per prevenire l’accumulo di ritardo. Whisper Turbo funziona 5,4 volte più velocemente di Whisper Large v3rendendo RTF inferiore a 1.0 realizzabile su larga scala senza API proprietarie.

Il vantaggio modulare: controllo e conformità

Per i settori regolamentati come quello sanitario e finanziario, “economico” e “veloce” sono secondari rispetto alla governance. I modelli S2S nativi funzionano come “scatole nere”, rendendo difficile verificare ciò che il modello ha elaborato prima di rispondere. Senza visibilità sui passaggi intermedi, le aziende non possono verificare che i dati sensibili siano stati gestiti correttamente o che l’agente abbia seguito i protocolli richiesti. Questi controlli sono difficili – e in alcuni casi impossibili – da implementare all’interno di sistemi vocali end-to-end opachi.

L’approccio modulare, invece, mantiene uno strato testuale tra trascrizione e sintesi, consentendo interventi statali impossibile con l’elaborazione audio end-to-end. Alcuni casi d’uso includono:

-

Redazione PII consente ai motori di conformità di scansionare il testo intermedio ed eliminare numeri di carte di credito, nomi di pazienti o numeri di previdenza sociale prima che entrino nel modello di ragionamento. Racconta le IA la redazione automatica dei dati personali sensibili dalle trascrizioni riduce significativamente il rischio di conformità, una funzionalità che Vapi non offre nativamente.

-

Iniezione di memoria consente alle aziende di inserire la conoscenza del dominio o la cronologia degli utenti nel contesto del immediate prima che LLM generi una risposta, trasformando gli agenti da strumenti transazionali in sistemi basati sulle relazioni.

-

Autorità nella pronuncia diventa fondamentale nei settori regolamentati in cui la pronuncia errata del nome di un farmaco o di un termine finanziario crea responsabilità. Nebbia di Brina v2 si concentra sulla pronuncia deterministica, consentendo alle aziende di definire dizionari di pronuncia rigorosamente rispettati per milioni di chiamate, una capacità che i modelli S2S nativi faticano a garantire.

Matrice di confronto tra architetture

La tabella seguente riassume il modo in cui ciascuna architettura viene ottimizzata per una diversa definizione di “pronto per la produzione”.

|

Caratteristica |

S2S nativo (mezza cascata) |

Modulare unificato (co-localizzato) |

Modulare legacy (concatenato) |

|

Giocatori principali |

Google Gemelli 2.5OpenAI in tempo reale |

Insieme AIVapi (in sede) |

Deepgram + Anthropic + ElevenLabs |

|

Latenza (TTFT) |

~200-300 ms (Livello umano) |

~300-500 ms (Quasi nativo) |

>500 ms (Ritardo notevole) |

|

Profilo dei costi |

Biforcato: I Gemelli hanno un’utilità bassa (~$0,02/min); OpenAI è premium (~$0,30+/min). |

Moderato/Lineare: Somma dei componenti (~$0,15/min). Nessuna “tassa di contesto” nascosta. |

Moderare: Simile a Unified, ma costi di larghezza di banda/trasporto più elevati. |

|

Stato/Memoria |

Basso: Apolide per impostazione predefinita. Difficile iniettare RAG a metà flusso. |

Alto: Controllo completo per inserire memoria/contesto tra STT e LLM. |

Alto: Integrazione RAG semplice, ma lenta. |

|

Conformità |

“Scatola nera”: Difficile controllare direttamente enter/output. |

Controllabile: Il livello di testo consente la redazione delle PII e i controlli delle coverage. |

Controllabile: Registri completi disponibili per ogni passaggio. |

|

Miglior caso d’uso |

Utilità advert alto quantity O Concierge. |

Impresa regolamentata: Sanità e finanza che richiedono percorsi di controllo rigorosi. |

IVR precedente: Routing semplice in cui la latenza è meno critica. |

L’ecosistema dei fornitori: chi vince dove

Il panorama dell’intelligenza artificiale vocale aziendale si è frammentato in livelli competitivi distinti, ciascuno dei quali serve segmenti diversi con una sovrapposizione minima. Ai fornitori di infrastrutture piace Deepgram e AssemblyAI competono in termini di velocità e accuratezza della trascrizione, come sostiene Deepgram Inferenza 40 volte più veloce rispetto ai servizi cloud standard E AssembleaAI contrastare con migliore precisione e velocità.

Fornitori di modelli Google E OpenAI competere sul rapporto prezzo-prestazioni con strategie radicalmente numerous. Il posizionamento di utilità di Google lo rende lo strumento predefinito per flussi di lavoro advert alto quantity e a basso margine, mentre OpenAI difende il livello premium con istruzione migliorata seguenti (30,5% sul benchmark MultiChallenge) e chiamata di funzioni migliorate (66,5% su ComplexFuncBench). Il divario si è ridotto da 15 a 4 volte nei prezzi, ma OpenAI mantiene il suo vantaggio in termini di espressività emotiva e fluidità conversazionale, qualità che giustificano prezzi premium per interazioni mission-critical.

Piattaforme di orchestrazione Vapi, Raccontare l’IAE IA blanda competere sulla facilità di implementazione e sulla completezza delle funzionalità. L’approccio di Vapi incentrato sullo sviluppatore si rivolge ai staff tecnici che desiderano un controllo granulare, mentre l’attenzione alla conformità di Retell (HIPAA, redazione automatica delle PII) lo rende l’impostazione predefinita per i settori regolamentati. Il modello di servizio gestito di Bland si rivolge ai staff operativi che desiderano una scalabilità “imposta e dimentica” a scapito della flessibilità.

Ai fornitori di infrastrutture unificate piace Insieme AI rappresentano l’evoluzione architetturale più significativa, comprimendo lo stack modulare in un’unica offerta che offre una latenza di tipo nativo pur mantenendo il controllo a livello di componente. Co-localizzando STT, LLM e TTS sui cluster GPU condivisi, Collectively AI raggiunge una latenza totale inferiore a 500 ms con ~ 225 ms per la generazione TTS utilizzando Mist v2.

La conclusione

Il mercato è andato oltre la scelta tra “intelligente” e “veloce”. Le aziende devono ora mappare i propri requisiti specifici (conformità, tolleranza alla latenza, vincoli di costo) all’architettura che li supporta. Per flussi di lavoro di servizi di pubblica utilità advert alto quantity che comportano interazioni di routine a basso rischio, Google Gemini 2.5 Flash offre un rapporto prezzo/prestazioni imbattibile a circa 2 centesimi al minuto. Per i flussi di lavoro che richiedono ragionamenti sofisticati senza sforare il funds, Gemelli 3Flash offre intelligenza di livello professionale a costi pari a quelli di Flash.

Per flussi di lavoro complessi e regolamentati che richiedono una governance rigorosa, l’applicazione di un vocabolario specifico o l’integrazione con sistemi back-end complessi, lo stack modulare offre il controllo e la verificabilità necessari senza le penalità di latenza che in precedenza ostacolavano i progetti modulari. Insieme, l’architettura co-locata di AI o l’orchestrazione basata sulla conformità di Retell AI rappresentano i contendenti più forti in questo caso.

L’architettura che sceglierai oggi determinerà se i tuoi agenti vocali potranno operare in ambienti regolamentati: una decisione molto più consequenziale rispetto a quale modello sembri più umano o ottenga il punteggio più alto nell’ultimo benchmark.