I ricercatori di Nvidia hanno sviluppato una tecnica in grado di ridurre fino a otto volte i costi di memoria del ragionamento basato su modelli linguistici di grandi dimensioni. La loro tecnica, chiamata Sparsificazione dinamica della memoria (DMS), comprime la cache dei valori chiave (KV), la memoria temporanea che i LLM generano e archiviano mentre elaborano richieste e ragionano su problemi e documenti.

Sebbene i ricercatori abbiano già proposto vari metodi per comprimere questa cache, la maggior parte fatica a farlo senza degradare l’intelligenza del modello. L’approccio di Nvidia riesce a scartare gran parte della cache mantenendo (e in alcuni casi migliorando) le capacità di ragionamento del modello.

Gli esperimenti dimostrano che il DMS consente agli LLM di “pensare” più a lungo ed esplorare più soluzioni senza le consuete penalità in termini di velocità o costi di memoria.

Il collo di bottiglia del ragionamento

Gli LLM migliorano le loro prestazioni su compiti complessi generando “catena di pensiero“, scrivendo essenzialmente i passaggi del ragionamento prima di arrivare a una risposta finale. Le tecniche di ridimensionamento del tempo di inferenza sfruttano questo aspetto fornendo al modello un finances più ampio per generare questi token di pensiero o per esplorare più potenziali percorsi di ragionamento in parallelo.

Tuttavia, questo ragionamento migliorato comporta un costo computazionale significativo. Man mano che il modello genera più token, costruisce a Cache KV.

Per le applicazioni del mondo reale, la cache KV rappresenta un grosso collo di bottiglia. Man mano che la catena di ragionamento cresce, la cache cresce in modo lineare, consumando grandi quantità di memoria sulle GPU. Ciò costringe l'{hardware} a dedicare più tempo alla lettura dei dati dalla memoria che all’elaborazione effettiva, il che rallenta la generazione e aumenta la latenza. Limita inoltre il numero di utenti che un sistema può servire contemporaneamente, poiché l’esaurimento della VRAM provoca l’arresto anomalo o il rallentamento del sistema.

I ricercatori di Nvidia inquadrano questo non solo come un ostacolo tecnico, ma come un ostacolo economico fondamentale per l’azienda.

“La domanda non riguarda solo la quantità di {hardware}; riguarda se la vostra infrastruttura sta elaborando 100 thread di ragionamento o 800 thread allo stesso costo”, ha detto a VentureBeat Piotr Nawrot, Senior Deep Studying Engineer di Nvidia.

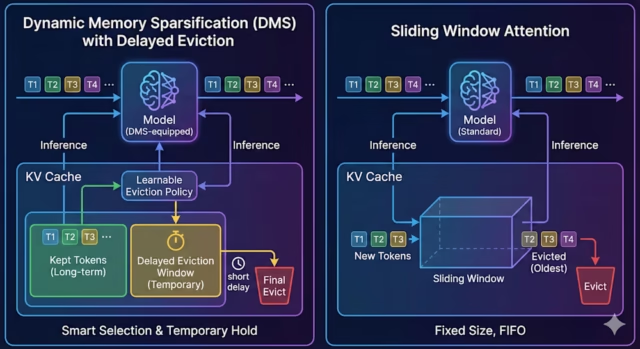

I precedenti tentativi di risolvere questo problema si sono concentrati su approcci basati sull’euristica. Questi metodi utilizzano regole rigide, come una “finestra scorrevole” che memorizza nella cache solo i token più recenti ed elimina il resto. Sebbene ciò riduca l’utilizzo della memoria, spesso costringe il modello a scartare le informazioni critiche necessarie per risolvere il problema, riducendo la precisione dell’output.

“I metodi di sfratto commonplace tentano di selezionare i token vecchi e non utilizzati per lo sfratto utilizzando l’euristica”, hanno affermato i ricercatori. “Semplificano il problema, sperando che, se si avvicinano ai meccanismi interni del modello, la risposta rimarrà corretta.”

Altre soluzioni utilizzano il paging per scaricare le parti inutilizzate della cache KV su una memoria più lenta, ma il costante scambio di dati introduce un sovraccarico di latenza che rende lente le applicazioni in tempo reale.

Sparsificazione dinamica della memoria

DMS adotta un approccio diverso “adattando” gli LLM esistenti per gestire in modo intelligente la propria memoria. Invece di applicare una regola fissa su cosa eliminare, DMS addestra il modello per identificare quali token sono essenziali per il ragionamento futuro e quali sono usa e getta.

“Non si limita a indovinare l’importanza; apprende una politica che preserva esplicitamente la distribuzione dell’output finale del modello”, ha detto Nawrot.

Il processo trasforma un LLM commonplace e pre-addestrato come Llama 3 o Qwen 3 in un modello autocompressivo. Fondamentalmente, ciò non richiede l’addestramento del modello da zero, che sarebbe proibitivamente costoso. Invece, DMS ripropone i neuroni esistenti all’interno degli strati di attenzione del modello per emettere un segnale “mantieni” o “sfratta” per ciascun token.

Per i crew preoccupati per la complessità dell’adeguamento, i ricercatori hanno notato che il processo è progettato per essere leggero. “Per migliorare l’efficienza di questo processo, i pesi del modello possono essere congelati, il che rende il processo simile all’adattamento di basso rango (LoRA)”, ha affermato Nawrot. Ciò significa che un modello aziendale commonplace come Qwen3-8B “può essere adattato con DMS in poche ore su un singolo DGX H100”.

Una delle parti importanti del DMS è un meccanismo chiamato “sfratto ritardato”. Nella sparsificazione commonplace, se un token viene ritenuto non importante, viene immediatamente eliminato. Questo è rischioso perché il modello potrebbe aver bisogno di una frazione di secondo per integrare il contesto di quel token nel suo stato attuale.

DMS mitiga questo problema contrassegnando un token per l’eliminazione ma mantenendolo accessibile per un breve periodo di tempo (advert esempio, alcune centinaia di passaggi). Questo ritardo consente al modello di “estrarre” tutte le informazioni necessarie rimanenti dal token e di unirle al contesto corrente prima che il token venga cancellato dalla cache KV.

“Il meccanismo di ‘sfratto ritardato’ è cruciale perché non tutti i token sono semplicemente ‘importanti’ (conservarli per sempre) o ‘inutili’ (cancellarli immediatamente). Molti si trovano nel mezzo: contengono alcune informazioni, ma non abbastanza da giustificare l’occupazione di un intero spazio in memoria”, ha detto Nawrot. “È qui che sta la ridondanza. Mantenendo questi token in una finestra locale per un breve periodo prima dello sfratto, consentiamo al modello di occuparsene e di ridistribuire le loro informazioni in token futuri.”

I ricercatori hanno scoperto che questo processo di retrofitting è altamente efficiente. Potrebbero equipaggiare un LLM pre-addestrato con DMS in soli 1.000 passaggi di formazione, una piccola frazione del calcolo richiesto per la formazione originale. I modelli risultanti utilizzano kernel commonplace e possono essere inseriti direttamente negli stack di inferenza advert alte prestazioni esistenti senza {hardware} personalizzato o riscrittura complessa del software program.

DMS in azione

Per convalidare la tecnica, i ricercatori hanno applicato il DMS a diversi modelli di ragionamento, tra cui la serie Qwen-R1 (distillata da DeepSeek R1) e Llama 3.2, e li hanno testati su benchmark difficili come AIME 24 (matematica), GPQA Diamond (scienza) e LiveCodeBench (codifica).

I risultati mostrano che il DMS sposta efficacemente la frontiera di Pareto, il compromesso ottimale tra costi e prestazioni. Nel benchmark matematico AIME 24, un modello Qwen-R1 32B dotato di DMS ha ottenuto un punteggio di 12,0 punti superiore rispetto a un modello commonplace quando vincolato allo stesso finances di larghezza di banda della memoria. Comprimendo la cache, il modello potrebbe permettersi di “pensare” in modo molto più profondo e più ampio di quanto potrebbe fare il modello commonplace con la stessa memoria e finances di calcolo.

Forse la cosa più sorprendente è che il DMS ha sfidato il luogo comune secondo cui la compressione danneggia la comprensione del contesto a lungo termine. Nei check “in the past nel pagliaio”, che misurano la capacità di un modello di trovare una specifica informazione sepolta in un documento di grandi dimensioni, le varianti DMS hanno effettivamente sovraperformato i modelli commonplace. Gestendo attivamente la propria memoria anziché accumulare passivamente rumore, il modello ha mantenuto un contesto più pulito e più utile.

Per le infrastrutture aziendali, i miglioramenti in termini di efficienza si traducono direttamente in throughput e risparmi sull'{hardware}. Poiché la cache di memoria è significativamente più piccola, la GPU impiega meno tempo a recuperare i dati, riducendo i tempi di attesa per gli utenti. Nei check con il modello Qwen3-8B, DMS ha eguagliato la precisione del modello Vanilla fornendo allo stesso tempo un throughput fino a 5 volte superiore. Ciò significa che un singolo server può gestire un numero di richieste dei clienti cinque volte superiore al secondo senza compromettere la qualità.

Il futuro della memoria

Nvidia ha rilasciato DMS come parte del suo Libreria KVPress. Per quanto riguarda le modalità con cui le imprese possono iniziare a utilizzare il DMS, Nawrot ha sottolineato che la barriera all’ingresso è bassa. “L’infrastruttura minima praticabile è rappresentata dalle pipeline commonplace di Hugging Face: non sono richiesti kernel CUDA personalizzati”, ha affermato Nawrot, sottolineando che il codice è completamente compatibile con FlashAttention commonplace.

Guardando al futuro, il crew vede il DMS come parte di un cambiamento più ampio in cui la gestione della memoria diventa un livello distinto e intelligente dello stack AI. Nawrot ha inoltre confermato che DMS è “pienamente compatibile” con le architetture più recenti come Attenzione latente multi-testa (MLA) utilizzati nei modelli di DeepSeek, suggerendo che la combinazione di questi approcci potrebbe produrre guadagni di efficienza ancora maggiori.

Mentre le aziende passano da semplici chatbot a complessi sistemi advert agenti che richiedono un ragionamento esteso, il costo dell’inferenza sta diventando una preoccupazione primaria. Tecniche come DMS forniscono un percorso per scalare queste capacità in modo sostenibile.

“Abbiamo appena scalfito la superficie di ciò che è possibile”, ha detto Nawrot, “e ci aspettiamo che il ridimensionamento del tempo di inferenza si evolva ulteriormente”.